Em cinco dias, mais de um milhão de pessoas se inscreveram para testá-lo, segundo Greg Brockman, presidente da OpenAI. Centenas de capturas de tela de conversas do ChatGPT se tornaram virais no Twitter, e muitos de seus primeiros fãs falam disso em termos surpreendentes e grandiosos, como se fosse uma mistura de software e feitiçaria. (Roose, 2022, n.p.)

O ChatGPT parece algo mágico: como ele consegue responder às nossas perguntas tão rapidamente e com tanta proficiência? Arthur C. Clarke formulou uma das leis mais conhecidas sobre ciência e tecnologia: “Qualquer tecnologia suficientemente avançada é indistinguível da magia” (Clarke, 1962). Como consequência dessa máxima, podemos deduzir que, quando tornamos uma tecnologia avançada suficientemente compreensível, desvendamos sua aura de magia, desmistificando-a. Algo semelhante foi afirmado na abertura do artigo sobre ELIZA, o primeiro sistema de chatbot da história:

Diz-se que explicar é diminuir a importância da coisa explicada. Essa máxima se realiza de maneira exemplar no campo da programação de computadores, especialmente no que é chamado de programação heurística e inteligência artificial. Nessas áreas, máquinas são feitas para se comportarem de maneiras surpreendentes, muitas vezes suficientes para deslumbrar até mesmo o observador mais experiente. No entanto, uma vez que um determinado programa é desmascarado, uma vez que seus mecanismos internos são explicados em linguagem suficientemente simples para possibilitar a compreensão, sua magia desmorona; ele se revela como uma mera coleção de procedimentos, cada um bastante compreensível. O observador diz a si mesmo: “Eu poderia ter escrito isso”. Com esse pensamento, ele move o programa em questão da prateleira marcada como “inteligente” àquela reservada para curiosidades, que serve para ser discutido apenas com pessoas menos esclarecidas que ele. (Weizenbaum, 1966, p. 36, tradução nossa)

Weizenbaum alertou o/a leitor/a que seu artigo daria fim à magia relacionada ao funcionamento de seu robô de conversação ELIZA. Esse é o nosso objetivo neste capítulo: desmistificar a IA generativa, fazer sua magia desmoronar. Para alcançarmos esse objetivo, explicamos como algumas técnicas conseguem fazer uma máquina tomar decisões inteligentes e gerar textos coerentes, demonstrando um tipo de inteligência.

Você não precisa saber programar computadores para compreender, em linhas gerais, como tudo funciona. Não pretendemos aqui ensinar a construir sistemas inteligentes, pois este não é um livro técnico sobre IA. Nosso objetivo é apresentar algumas noções em alto nível, suficientes para compreender o funcionamento de tecnologias generativas como o ChatGPT. Para essa finalidade, discutiremos noções como algoritmo, raciocínio computacional, aprendizagem de máquina (machine learning), rede neural artificial, aprendizagem profunda (deep learning), modelo de linguagem, treinamento não supervisionado, Transformer, entre outras.

Se você, leitor/a, não deseja saber como tudo funciona, pode pular este capítulo sem prejuízo para a compreensão do restante do livro. Este capítulo foi escrito para quem se encontra inquieta/o querendo saber como a IA é capaz de gerar textos, para tentar saciar um pouco da sede das/os que são “epistemologicamente curiosas/os”, como lindamente caracterizado por Paulo Freire (2015 [1996], p.33-34):

A curiosidade como inquietação indagadora, como inclinação ao desvelamento de algo, como pergunta verbalizada ou não, como procura de esclarecimento, como sinal de atenção que sugere alerta faz parte integrante do fenômeno vital. Não haveria criatividade sem a curiosidade que nos move e que nos põe pacientemente impacientes diante do mundo que não fizemos, acrescentando a ele algo que fazemos. Como manifestação presente à experiência vital, a curiosidade humana vem sendo histórica e socialmente construída e reconstruída. Precisamente porque a promoção da ingenuidade para a criticidade não se dá automaticamente, uma das tarefas precípuas da prática educativo-progressista é exatamente o desenvolvimento da curiosidade crítica, insatisfeita, indócil. Curiosidade com que podemos nos defender de “irracionalismos” decorrentes do ou produzidos por certo excesso de “racionalidade” de nosso tempo altamente tecnologizado. E não vai nesta consideração nenhuma arrancada falsamente humanista de negação da tecnologia e da ciência. Pelo contrário, é consideração de quem, de um lado, não diviniza a tecnologia, mas, de outro, não a diaboliza. De quem a olha ou mesmo a espreita de forma criticamente curiosa.

Compreender como a inteligência artificial generativa funciona, ainda que em linhas gerais, pode desconstruir tanto a divinização quanto a demonização dessa tecnologia, pode desfazer alguns equívocos e esclarecer dúvidas. Esse tipo de conhecimento também é necessário para afiar nossa capacidade de análise crítica das tecnologias generativas que continuarão a ser desenvolvidas e com as quais conviveremos cada vez mais em nosso cotidiano.

Russell e Norvig (2022, n.p.), cujas obras são referência para diversos cursos de IA, encontraram uma maneira interessante de resumir a história da área:

Uma forma rápida de resumir os marcos da história da IA é listar os vencedores do Prêmio Turing: Marvin Minsky (1969) e John McCarthy (1971) pela definição dos fundamentos do campo com base na representação e no raciocínio; Ed Feigenbaum e Raj Reddy (1994) pelo desenvolvimento de sistemas especialistas, que codificam o conhecimento humano para resolver problemas do mundo real; Judea Pearl (2011) pelo desenvolvimento de técnicas de raciocínio probabilístico que lidam com a incerteza de um modo baseado em princípios; e, finalmente, Yoshua Bengio, Geoffrey Hinton e Yann LeCun (2019) por tornar o “aprendizado profundo” (redes neurais multicamadas) uma parte crítica da computação moderna.

Nas próximas seções, discutiremos essas e outras técnicas que representam marcos históricos da IA, pois elas nos ajudam a compreender o funcionamento das tecnologias generativas. Decidimos começar desmistificando o funcionamento do primeiro chatbot, ELIZA, mostrando algumas semelhanças e diferenças com as atuais técnicas de Processamento de Linguagem Natural (PLN), que é a subárea da IA dedicada a capacitar máquinas para compreender e gerar textos nas línguas faladas por seres humanos, como o português, inglês ou chinês.

12.1 – ELIZA e o Processamento de Linguagem Natural (PLN)

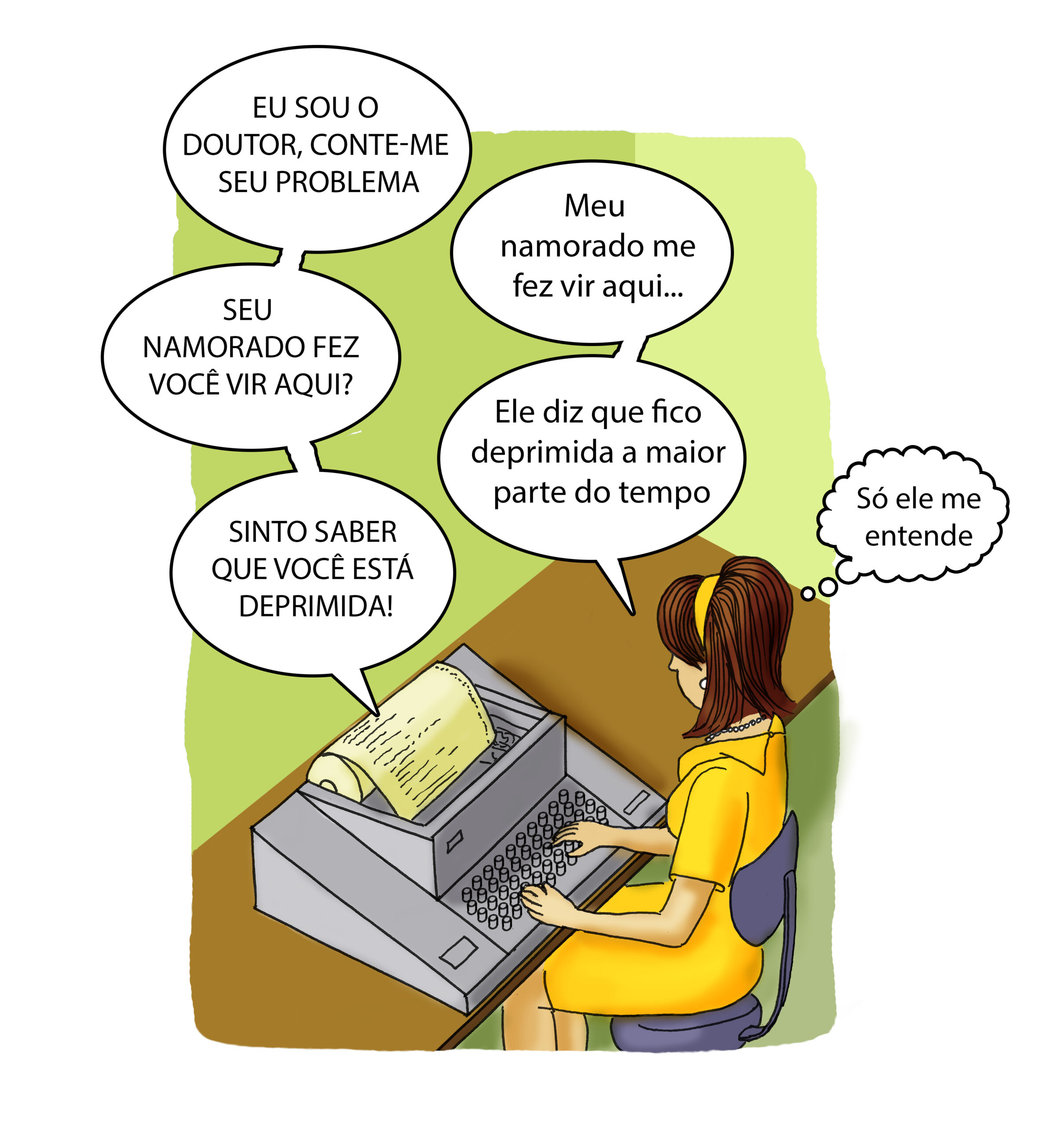

Fonte: dos autores, ilustração de Mônica Lopes com base em Weixenbaum (1966)

ELIZA é a antepassada mais distante do ChatGPT, sua progenitora primordial, lançada por Joseph Weizenbaum em 1966 no artigo ELIZA – Um Programa de Computador para o Estudo da Comunicação em Linguagem Natural entre Homem e Máquina[1]. Esse é um importante marco histórico, pois é considerado o primeiro chatbot: um programa capaz de simular uma conversação com seres humanos. Os enunciados de ELIZA eram baseados em um roteiro de conversação (script), sendo o mais famoso o DOCTOR, que imitava o comportamento conversacional de um psicoterapeuta. Naquela época, as pessoas não conheciam robôs de conversação, e ainda era uma novidade a computação interativa possibilitada pelo teletipo (uma máquina de escrever eletromecânica).

O DOCTOR buscava imitar o comportamento de fala de um psicoterapeuta rogeriano, cuja técnica de terapia, desenvolvida pelo psicólogo Carl Rogers, consiste em aprofundar o que foi dito pela/o paciente, devolvendo à/ao paciente suas próprias declarações para que ela/e reflita sobre suas falas, promovendo o autoconhecimento e a autoaceitação, sem que a/o terapeuta apresente interpretações ou diagnósticos para a/o paciente. O exemplo apresentado no artigo original é de uma conversa entre o DOCTOR e uma mulher:

COMO VOCÊ VAI? EU SOU O DOUTOR. POR FAVOR, SENTE-SE AO TELETIPO E CONTE-ME SEU PROBLEMA.

> Os homens são todos iguais.

DE QUE MANEIRA?

> Eles estão sempre nos incomodando sobre uma coisa ou outra.

VOCÊ PODE SER MAIS ESPECÍFICO?

> Bem, meu namorado me fez vir aqui.

SEU NAMORADO FEZ VOCÊ VIR AQUI?

> Ele diz que fico deprimida a maior parte do tempo.

SINTO SABER QUE VOCÊ ESTÁ DEPRIMIDA

> É verdade. Eu estou infeliz

VOCÊ ACHA QUE VIR AQUI VAI TE AJUDAR A NÃO FICAR INFELIZ?

> Eu preciso de ajuda, isso sim.

O QUE SIGNIFICARIA PARA VOCÊ SE CONSEGUISSE ESSA AJUDA?

> Talvez eu possa aprender a me relacionar melhor com minha mãe.

CONTE-ME MAIS SOBRE SUA FAMÍLIA

> Minha mãe cuida de mim.

QUEM MAIS NA SUA FAMÍLIA CUIDA DE VOCÊ?

> Meu pai.

SEU PAI

> Você é parecido com meu pai em alguns aspectos.

QUAL SEMELHANÇA VOCÊ VÊ?

> Você não é muito agressivo, mas acho que você não quer que eu perceba isso.

O QUE FAZ VOCÊ ACHAR QUE EU NÃO SOU MUITO AGRESSIVO?

> Você não discute comigo.

POR QUE VOCÊ ACHA QUE EU NÃO DISCUTO COM VOCÊ?

> Porque você tem medo de mim.

AGRADA-LHE ACREDITAR QUE EU TENHO MEDO DE VOCÊ?

> Meu pai tem medo de todo mundo.

O QUE MAIS VEM À SUA MENTE QUANDO VOCÊ PENSA EM SEU PAI?

> Valentões.

ISSO TEM ALGO A VER COM O SEU NAMORADO?

> […]

(Weizenbaum, 1966, p. 36-37, tradução nossa, com acréscimo da primeira linha, que se encontra no código original)

Os códigos-fonte de ELIZA e do roteiro DOCTOR foram divulgados publicamente em 2021 e agora encontram-se em domínio público no site ELIZAGEN. Esses códigos são de interesse histórico, pois registram as técnicas de programação empregadas à época na construção desse primeiro robô de conversação.

O funcionamento de ELIZA baseia-se na transformação do texto digitado pela/o usuária/o em um novo texto a ser apresentado como resposta. Por exemplo, se a pessoa digitasse um texto contendo a palavra “sonho” ou “sonhei”, o programa escolhia uma das frases a seguir como resposta:

O QUE ESSE SONHO SUGERE PARA VOCÊ?

VOCÊ SONHA FREQUENTEMENTE?

QUE PESSOAS APARECEM NOS SEUS SONHOS?

VOCÊ ACREDITA QUE ESSE SONHO TEM ALGO A VER COM O SEU PROBLEMA?

Além da palavra-chave, o programa podia montar a resposta utilizando alguma informação contida no texto de entrada:

> Estou muito infeliz

HÁ QUANTO TEMPO VOCÊ ESTÁ MUITO INFELIZ?

Por exemplo, quando a/o usuária/o digitava “Estou muito infeliz”, o programa reconhecia que a frase seguia o modelo “Estou *”, onde * representa qualquer coisa digitada pela/o usuária/o, nesse exemplo, foi digitado “muito infeliz”. Uma possível resposta associada a esse modelo de frase era “Há quanto tempo você está *?”, substituindo-se o * pelo trecho digitado pela/o usuária/o. Quando nenhuma palavra-chave era identificada no texto digitado, o sistema selecionava uma resposta genérica ou uma mensagem que mudava de assunto, como: “Por favor, continue.”; “Entendo.”; “Você pode ser mais específico?”. Também podia reutilizar alguma informação digitada anteriormente. Essa técnica de processamento de texto, que repete algo digitado pela/o usuária/o, cria a ilusão de que a máquina entendeu o que a pessoa digitou, o que favorece a continuidade da conversa.

Ao compreendermos o funcionamento de ELIZA, fica evidente que esse programa não desenvolveu uma inteligência capaz de pensar sobre tudo ou sobre si mesmo. Ele não pensa nem compreende o sentido das palavras. Trata-se de um jogo para simular uma conversa, com base em regras predefinidas para processar o texto buscando palavras-chave e padrões de frases.

De acordo com Weizenbaum (1976), o programa ELIZA se tornou popular no Instituto de Tecnologia de Massachusetts (MIT) por demonstrar vividamente o poder de processamento de informação dos computadores à época. Os efeitos causados nas/os usuárias/os, que se sentiam conversando e estabeleciam laços afetivos com a máquina, impressionaram Weizenbaum:

Fiquei surpreso ao ver a rapidez e profundidade com que as pessoas que conversavam com DOCTOR se envolveram emocionalmente com o computador e como, inequivocamente, o antropomorfizaram. Certa vez, minha secretária, que havia me observado trabalhar no programa por muitos meses e, portanto, certamente sabia que era apenas um programa de computador, começou a conversar com ele. Depois de apenas algumas interações com ele, ela me pediu para sair da sala [para ter privacidade para conversar com a máquina]. Em outra ocasião, sugeri que eu poderia configurar o sistema para examinar todas as conversas que alguém teve com ele, digamos, durante a noite. Fui prontamente bombardeado com acusações de que o que eu propunha era espionar os pensamentos mais íntimos das pessoas; uma clara evidência de que elas estavam conversando com o computador como se ele fosse uma pessoa com quem se pode falar de forma apropriada e íntima. […] O que eu não havia percebido é que exposições extremamente curtas a um programa de computador relativamente simples poderiam induzir pensamentos altamente ilusórios em pessoas perfeitamente normais. Esse insight me levou a atribuir nova importância às questões da relação entre o indivíduo e o computador. […] Essa reação a ELIZA me mostrou, de forma mais vívida do que tudo o que eu já tinha visto antes, as atribuições enormemente exageradas que mesmo pessoas bem instruídas são capazes de fazer, e até se esforçam para fazer, a uma tecnologia que não compreendem. (Weizenbaum, 1976, p. 6, tradução nossa)

Apesar de Weizenbaum explicar que ELIZA não era capaz de compreender as conversas, muitas pessoas que interagiram com o programa acreditavam que ele realmente entendia o que elas diziam e se importava com elas. Esse fenômeno ficou conhecido como Efeito ELIZA.

Em função dos efeitos causados pela interação com ELIZA, Weizenbaum (1976) passou a considerar que a IA poderia representar um perigo à sociedade. Sua preocupação era de que a computação reforçasse a visão do ser humano como máquina, fazendo com que nos percebêssemos como meros autômatos, reconhecendo-nos “como nada além de uma engrenagem” e acreditando que os avanços técnicos e científicos poderiam “levar o ser humano a uma visão cada vez mais racionalista de sua sociedade e uma imagem cada vez mais mecanicista de si mesmo”. Para o autor, essa concepção poderia levar à impressão de perda da autonomia e da nossa própria “essência humana”. O receio de Weizenbaum de nos compreendermos como uma espécie de programa de computador já foi tema de diversos episódios da série Black Mirror, como San Junipero (2016, 3ª temporada, 4º episódio), Hang the DJ (2017, 4ª temporada, 4º episódio) e A Joan é Péssima (Joan Is Awful, 2023, 6ª temporada, 1ª episódio).

Podemos estabelecer algumas comparações, ainda que grosseiras, entre ELIZA e o ChatGPT, para evidenciar que esse último é muito mais elaborado. É interessante notar que o programa ELIZA possuía apenas 409 linhas de código[2], o que é considerado um programa pequeno, possível de ser criado por uma única pessoa. De forma semelhante, o código-fonte do módulo de inferência do modelo GPT-2[3], isolado das bibliotecas auxiliares, também é relativamente compacto, com cerca de mil linhas de código. Contudo, essas linhas de código representam uma pequena parte do projeto como um todo. A maior complexidade está no processo de treinamento do modelo de linguagem, que envolve o processamento de uma enorme quantidade de dados que não fazem parte do código do programa. Assim, a inteligência do GPT emerge dos padrões aprendidos a partir dos dados processados, e não é previamente codificada pelas/os programadoras/es.

A diferença entre ELIZA e o ChatGPT torna-se ainda mais evidente ao compararmos as bases textuais utilizadas por cada um. O roteiro de conversação DOCTOR, documentado no artigo de Weizenbaum[4], contém apenas 8.520 caracteres (incluindo os espaços em branco), o que equivale a 3 ou 4 páginas de texto[5] e requer apenas 8,5KB de armazenamento em arquivo de computador[6]. Já o modelo de linguagem GPT-3 processou milhares de livros, toda a Wikipédia e uma imensa quantidade de textos da internet, totalizando 45TB de texto antes da filtragem e 570 GB após a filtragem, o que representa 8 ordens de grandeza superior ao roteiro de conversação do DOCTOR. Essa diferença entre as bases textuais equivale, em termos de ordem de grandeza, à comparação entre uma única pessoa e 100 milhões de pessoas (aproximadamente metade da população brasileira).

Apesar da simplicidade de ELIZA e da limitação do roteiro de conversação DOCTOR, já era possível criar uma ilusão de entendimento e inteligência, fazendo algumas/uns usuárias/os acreditarem que estavam interagindo com um ser consciente, ainda que essa ilusão durasse apenas algumas poucas interações. Esse programa de conversação possibilitou a primeira experimentação prática do Teste de Turing e estabeleceu os fundamentos para o desenvolvimento de chatbots e de algumas técnicas de processamento de linguagem natural.

Weizenbaum (1976, p. 6) caracterizou ELIZA como uma “simples paródia mecânica de uma técnica de entrevista”. Fica evidente a superioridade da atual tecnologia generativa quando comparamos as respostas dadas por ELIZA-DOCTOR, apresentadas no artigo original, e as fornecidas pelo ChatGPT[7]. Isso nos faz questionar: ELIZA era inteligente?

O programa ELIZA seguia um conjunto de regras predefinidas para o processamento de linguagem natural. ELIZA não possuía capacidade de raciocínio nem de aprendizagem, características que distinguem os sistemas contemporâneos de inteligência artificial. Portanto, à luz dos critérios atuais, ELIZA não seria considerado um programa inteligente no sentido contemporâneo do termo.

12.2 – Fazendo um computador jogar xadrez: representação simbólica, regras e raciocínio

Na abordagem simbólica, cria-se uma representação do mundo que possibilita ao computador analisá-la, tirar conclusões e tomar decisões. Um exemplo clássico dessa abordagem é o raciocínio computacional aplicado ao jogo de xadrez. Essa abordagem, que predominou nas primeiras décadas de desenvolvimento da IA, é discutida nesta seção para ilustrar como se pode fazer um computador agir de forma inteligente. Contudo, a IA generativa baseia-se em uma lógica distinta: a abordagem estatístico-conexionista, que se consolidou como a principal vertente da área nas últimas décadas, como será discutido nas seções seguintes.

Para que o computador seja capaz de raciocinar, o primeiro passo é construir uma representação simbólica do jogo, como no exemplo a seguir.

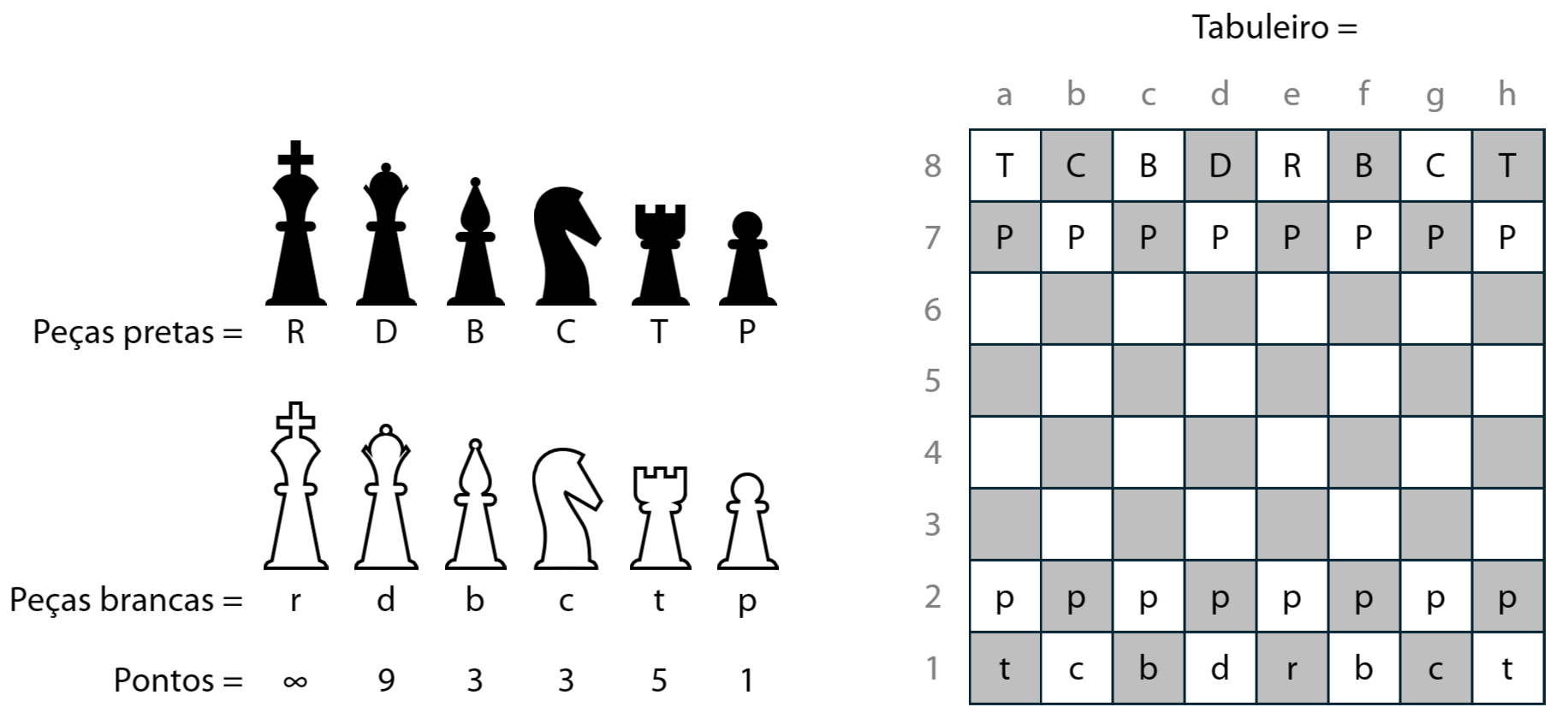

Fonte: dos autores

Podemos representar um tabuleiro de xadrez por meio de uma tabela composta por 8 linhas e 8 colunas, também chamada de matriz 8×8. As peças do tabuleiro podem ser representadas por letras: R representa o Rei; D, a Dama (ou rainha); B, o Bispo; C, o Cavalo, T, a Torre, e P, o Peão. Letras em maiúsculo representam peças pretas, enquanto letras em minúsculo representam peças brancas. As representações das peças devem ser posicionadas na matriz conforme sua disposição real no tabuleiro. A ausência de um caractere indica que a casa está vazia.

Com essa representação computacional do tabuleiro e as regras de movimentação de cada tipo de peça, é possível construir um roteiro de ações para que o computador possa jogar. Esse roteiro é o que chamamos de algoritmo: um conjunto de instruções que o computador executa para realizar uma tarefa, resolver um problema ou alcançar um objetivo. No caso do xadrez, o algoritmo deve decidir qual peça mover a cada jogada. Uma jogada consiste em mover uma peça de uma célula da matriz para outra célula. Por exemplo, mover o peão branco da casa b2 para b3 implica colocar um caractere vazio na célula b2 e a letra ‘p’ na célula b3, atualizando o estado do jogo.

Um algoritmo não-inteligente simplesmente sortearia uma peça e realizaria qualquer movimento válido, sem considerar a situação do jogo. Esse comportamento não é considerado inteligente, pois resulta de uma decisão aleatória que não produz uma jogada plausível em função do estado atual da partida. Para que um algoritmo seja considerado inteligente, é necessário que realize algum tipo de raciocínio. No caso do xadrez, é preciso avaliar os movimentos possíveis e escolher aquele que representa a melhor decisão para a situação em questão.

Para que o computador seja capaz de avaliar uma jogada, é necessário definir uma “função de avaliação”. Essa função indica se um determinado movimento resultará ou não na captura de uma peça adversária. O objetivo é capturar as peças mais valiosas do oponente, preferencialmente o rei, que é o objetivo final do jogo. Para isso, atribuímos uma pontuação a cada tipo de peça, conforme sua importância: Peão = 1 ponto; Cavalo = 3 pontos; Bispo = 3 pontos; Torre = 5 pontos; Dama (ou rainha) = 9 pontos; e o Rei tem valor infinito. Assim, a função de avaliação retorna a quantidade de pontos associada à peça capturada; ou retorna zero, caso o movimento leve a uma casa vazia.

Com base nessa função, podemos descrever um algoritmo simples para decidir qual peça o computador deve mover em uma jogada. O primeiro passo é identificar, para cada peça do computador, todos os movimentos possíveis. Em seguida, o algoritmo verifica, para cada movimento, se ele resulta na captura de uma peça adversária. Caso haja captura, calcula-se a pontuação correspondente com base na função de avaliação. Durante esse processo, o algoritmo compara os pontos obtidos em cada jogada e mantém em memória o movimento com maior valor. Ao final da análise, o movimento com maior ganho é selecionado como a “melhor jogada”. Se nenhum dos movimentos resultar na captura de uma peça (isto é, todos gerarem zero pontos), o algoritmo simplesmente escolhe aleatoriamente um dos movimentos válidos.

Acabamos de descrever um algoritmo baseado em inteligência artificial, pois o computador avalia o estado do jogo e toma uma decisão coerente: capturar, sempre que possível, a peça de maior valor da/o adversária/o. Trata-se de uma estratégia simples (descrevemos um “algoritmo ganancioso” muito elementar), que exige poucos cálculos. Cada jogador/a tem, no máximo, 16 peças, e nem todas estão disponíveis para movimentação em todos os momentos. No início do jogo, o número de possibilidades é pequeno, já que várias peças estão bloqueadas. À medida que a partida avança, o número de movimentos possíveis cresce. Em média, uma jogada dispõe de cerca de 35 movimentos possíveis. Assim, para decidir qual peça mover, o computador precisa avaliar, em média, 35 alternativas.

Podemos formular uma estratégia mais elaborada para que o computador jogue de forma mais inteligente. Em vez de simplesmente buscar capturar a peça adversária mais valiosa, o algoritmo pode considerar também as possíveis reações da/o oponente, avaliando todos os contra-ataques que podem ocorrer após cada jogada do computador. Por exemplo, suponha que o computador capture um peão, ganhando 1 ponto. No entanto, se na jogada seguinte a/o adversária/o puder capturar uma torre do computador, isso representará uma perda de 5 pontos, resultando em saldo negativo de -4 pontos, o que é uma clara desvantagem. Nessa situação, a captura do peão não parece ser a melhor decisão. Pode haver outro movimento mais vantajoso, no qual a/o adversária/o não tenha a oportunidade de capturar uma peça de valor igual ou superior.

Considerando essa estratégia, podemos elaborar um algoritmo que possibilite ao computador raciocinar de forma mais refinada antes de tomar uma decisão. Para cada movimento possível de todas as peças do computador, calcula-se quantos pontos seriam obtidos com o movimento e, em seguida, analisam-se todos os possíveis contra-ataques da/o adversária/o, identificando qual deles causaria a maior perda ao computador. O saldo de cada movimento é calculado pela diferença entre os pontos ganhos no ataque e os pontos perdidos no contra-ataque. Após avaliar todas as jogadas possíveis, o algoritmo escolhe aquela que resultar na maior pontuação para o computador.

Esse algoritmo já é mais elaborado do que o anterior, pois, além de considerar os movimentos do computador, também antecipa as possíveis reações da/o adversária/o. Isso exige mais cálculos: o computador precisa avaliar, em média, 35 movimentos próprios e, para cada um, considerar 35 possíveis contra-ataques da/o oponente, totalizando 35 × 35 = 1.225 combinações a serem analisadas.

É fácil perceber que o algoritmo pode ser aprimorado com a inclusão de um terceiro nível de análise: o computador joga, a/o adversária/o reage e, então, o computador joga novamente. Nesse caso, a quantidade média de movimentos a serem avaliados sobe para 35 × 35 × 35 = 42.875 combinações. A cada novo nível de antecipação, o número de combinações cresce exponencialmente. Por exemplo, ao tentar prever 10 jogadas à frente, o computador teria que analisar aproximadamente 35¹⁰ = 2.758.547.353.515.625 possibilidades — um fenômeno conhecido como explosão combinatória, que torna inviável a escolha da melhor jogada dentro do tempo disponível para a decisão, devido à imensa carga computacional exigida.

Como é impraticável realizar todos os cálculos para determinar qual movimento oferece a maior chance de vitória, torna-se necessário lidar com incertezas e tomar decisões estratégicas. Uma abordagem comum é o uso de buscas heurísticas, que consistem em identificar os caminhos mais promissores dentro de um espaço de possibilidades, sem a necessidade de avaliar todas as opções disponíveis.

Os algoritmos realmente utilizados para fazer o computador jogar xadrez são muito mais sofisticados do que os apresentados nesta seção, pois combinam diversas técnicas de inteligência artificial. A função de avaliação também tende a ser mais complexa, incorporando múltiplos fatores, como a segurança do rei, o controle do centro do tabuleiro, o desenvolvimento das peças, entre outros.

O algoritmo simplificado aqui discutido tem como objetivo ilustrar como é possível dotar o computador de uma forma básica de raciocínio, por meio da aplicação de regras lógicas sobre uma representação simbólica de um domínio do mundo real; neste caso, o tabuleiro de xadrez. Esse tipo de abordagem possibilita realizar avaliações e tomar decisões coerentes diante de incertezas, o que caracteriza a chamada inteligência artificial simbólica.

Jogar xadrez é um exemplo clássico de sistema inteligente que simula um dos aspectos da inteligência humana: a capacidade de raciocinar com base em regras para tomar decisões plausíveis em situações de incerteza, mobilizando um processo lógico de deliberação sobre a tarefa a ser executada. Outra característica da inteligência humana que as máquinas podem simular é a capacidade de aprender, o que discutiremos na seção a seguir.

12.3 – Aprendizagem de máquina[8]: o autodidatismo computacional

A IA generativa aprende com os dados durante seu processo de treinamento. Embora existam sistemas baseados em regras fixas capazes de resolver problemas específicos, atualmente a maior parte da pesquisa em IA associa inteligência à capacidade de aprender e melhorar o desempenho a partir de dados ou experiências. Por exemplo, um sistema especialista na área médica pode conter uma regra do tipo: “SE a pessoa apresenta o sintoma X e o sintoma Y, ENTÃO o diagnóstico é Z”. Esse tipo de sistema é capaz de diagnosticar doenças com base em um conjunto pré-definido de regras, mas não aprende a reconhecer novos sintomas ou enfermidades sem que uma pessoa insira manualmente novas regras.

Os primeiros sistemas especialistas foram desenvolvidos nas décadas de 1960 e 1970. O DENDRAL, lançado em 1965, foi projetado para inferir a estrutura molecular de compostos químicos. Já o MYCIN, desenvolvido no início da década de 1970, foi concebido para identificar bactérias causadoras de infecções graves e recomendar planos de tratamento com antibióticos: “Com cerca de 450 regras, o MYCIN era capaz de se sair tão bem quanto alguns especialistas e muito melhor do que médicos em início de carreira” (Russel; Norvig, 2022, n.p.). Esses sistemas buscavam imitar o processo de raciocínio e tomada de decisão de pessoas especialistas em suas respectivas áreas de conhecimento.

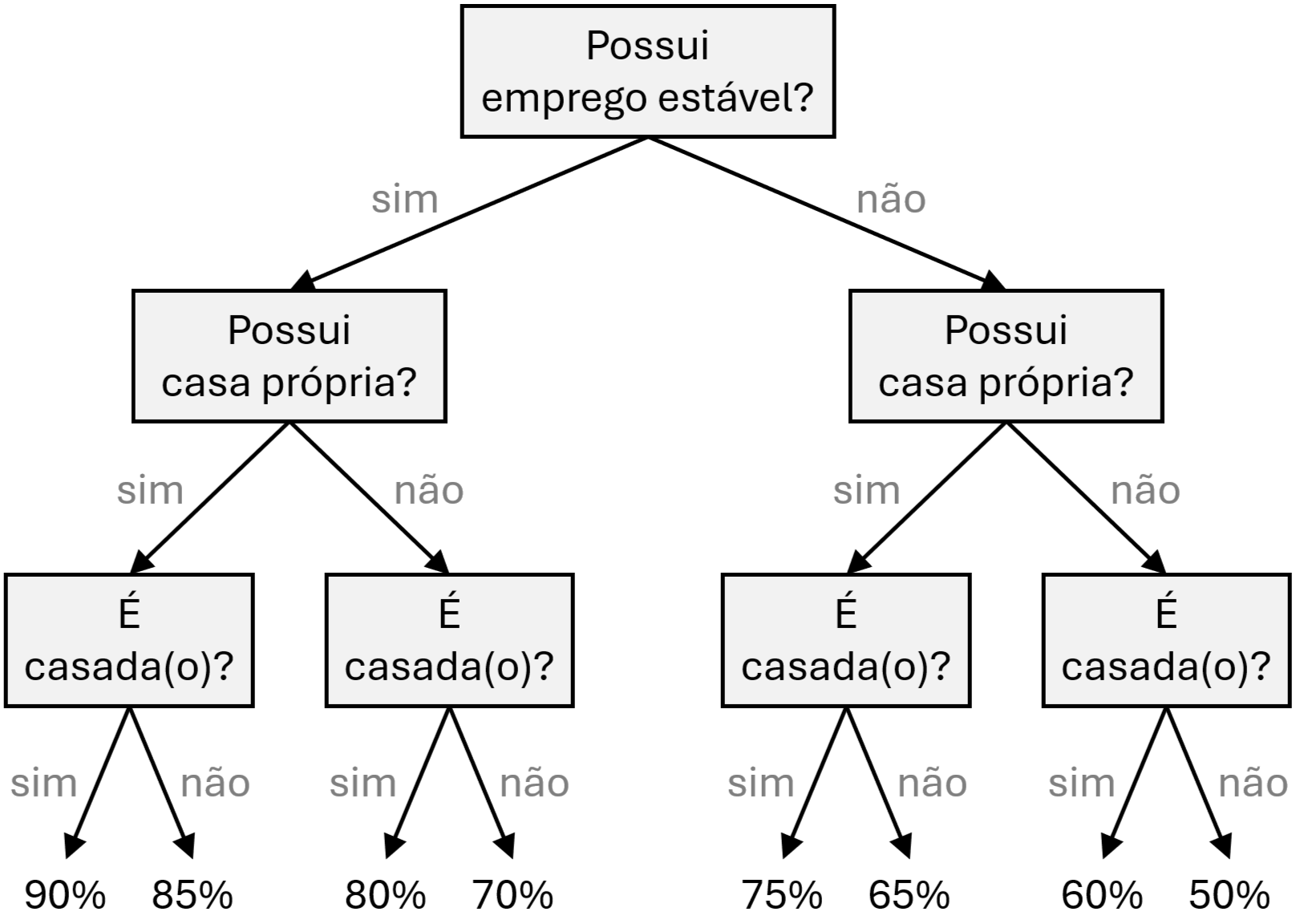

Esses sistemas especialistas utilizavam regras declaradas manualmente (“SE-ENTÃO”) e um motor de inferência para tomar decisões com base em conhecimento codificado por pessoas especialistas. Essa lógica condicional também é empregada na criação de modelos de árvore de decisão, como exemplificado na figura a seguir, que ilustra a probabilidade de uma pessoa quitar um empréstimo em um banco.

Fonte: dos autores

Percorremos (ou lemos) uma árvore de decisão de cima para baixo. Cada nó interno representa um teste condicional (“SE”) baseado em um atributo. No exemplo apresentado, o primeiro teste da árvore (o nó-raiz) verifica se a pessoa possui emprego estável. A resposta a esse teste determina o caminho a seguir: se a condição for satisfeita, seguimos para o ramo à esquerda; caso contrário, seguimos para o ramo à direita. Esse processo continua até alcançarmos um nó-folha (ou terminal), que contém a informação final desejada. Por exemplo, uma pessoa que tem emprego estável, possui casa própria e é casada tem 90% de probabilidade de quitar o empréstimo. Já uma pessoa que não tem emprego estável, possui casa própria e não é casada tem uma probabilidade de 65% de quitar o empréstimo. Esse tipo de modelo pode ser útil para apoiar decisões como conceder ou negar um empréstimo, ou para estimar o valor do seguro associado ao empréstimo. O objetivo de uma árvore de decisão é construir um modelo capaz de prever o valor de uma variável de destino (como a probabilidade de quitar um empréstimo), com base em várias variáveis de entrada (como emprego estável, propriedade de imóvel e estado civil).

Quando se deseja construir uma árvore de decisão que leve em conta muitas variáveis e seja capaz de identificar padrões mais complexos, é necessário utilizar uma grande quantidade de dados. Por exemplo, uma instituição financeira pode dispor de uma base extensa de informações sobre clientes que já contrataram empréstimos nos últimos cinco anos, incluindo dados sobre quem quitou ou não a dívida, além de outros atributos relevantes sobre as/os clientes e os empréstimos. O modelo gerado a partir desses dados reais tende a ser muito mais complexo do que o exemplo simplificado aqui apresentado, contendo um número significativamente maior de nós e níveis. Esse tipo de modelo costuma ser construído por meio de algoritmos de aprendizagem de máquina, que analisam os dados em busca de padrões e relações, gerando um modelo preditivo. Dessa forma, o computador torna-se capaz de prever resultados que não foram explicitamente programados, mas sim aprendidos com base no processamento dos dados. Esse processo exemplifica a capacidade de aprendizagem da máquina em transformar dados brutos em modelos capazes de prever e apoiar decisões.

A aprendizagem de máquina possibilita que um sistema melhore seu desempenho em uma tarefa específica com base em dados e experiência, sem que precise ser explicitamente programado por uma pessoa. Existem diferentes abordagens de aprendizagem de máquina. A IA generativa é um exemplo de modelo construído com base nessa abordagem. A maior parte dos modelos de IA generativa de grande escala utiliza arquiteturas de aprendizagem profunda (deep learning), como será abordado adiante.

12.4 – Modelo de linguagem: representação das línguas humanas

No contexto da IA, um modelo é uma estrutura matemática que representa uma determinada realidade de forma simplificada, tornando possível que um computador processe informações com o objetivo de realizar uma tarefa, tirar conclusões ou fazer previsões. Já apresentamos um modelo matemático do tabuleiro de xadrez, representado por uma matriz 8×8 contendo as representações das peças. Também discutimos a Árvore de Decisão, que é um modelo composto por uma sequência de decisões baseadas em regras. A IA generativa de texto também se baseia em um modelo de linguagem, conforme discutiremos nesta seção.

Um modelo de linguagem é um tipo específico de modelo construído para processar as línguas humanas. Sua tarefa básica consiste em prever a próxima palavra de um texto, considerando as palavras anteriores. Mesmo antes do ChatGPT, os modelos de linguagem já estavam presentes no cotidiano, como na função de autocompletar dos smartphones, que sugere palavras para completar a frase que está sendo digitada pela/o usuária/o. Vamos fazer uma brincadeira: no WhatsApp, digite a frase “A inteligência artificial pode ser” e, em seguida, vá aceitando sempre a primeira palavra sugerida pelo sistema de autocompletar para observar qual frase será gerada. Em nossos smartphones, as frases geradas foram:

Smartphone de Mariano: A inteligência artificial pode ser um ataque contra as mulheres que não é um risco para as pessoas que estão no mesmo lugar que neva e não há mais nada que precisemos fazer uma apresentação de um artigo e outras obras […]

Smartphone de Felipe: A inteligência artificial pode ser dia a dia e a gente não pode ser dia de semana que vem e não tem nada a ver com o que é feito no site do site e não o que é feito no site do site e […]

Os modelos de linguagem que vêm nos smartphones são muito mais limitados do que os atuais modelos de IA generativa de grande escala. A diretora de tecnologia da OpenAI, Mira Murati, explicou:

ChatGPT é uma rede neural [artificial] que foi treinada com uma enorme quantidade de dados em um enorme supercomputador; e o objetivo durante esse processo de treinamento era prever a próxima palavra em uma frase. O que acontece é que à medida em que você treina modelos cada vez maiores, adiciona mais e mais dados, as capacidades desses modelos também aumentam, e eles se tornam mais poderosos e mais úteis também. (Bloomberg, 2023, 3:30s–4:14s)

Adivinhar a próxima palavra em uma frase é o que a IA generativa de texto faz, mas com muito mais coerência do que a função de autocompletar de nossos smartphones. Vejamos como tudo isso funciona. Que palavra você escolheria para completar a frase a seguir?

A inteligência artificial pode ser _________

Podemos levantar algumas palavras que completariam bem essa frase: “útil”, “surpreendente”, “compreendida”, “uma”, “aplicada” etc. Outras palavras seriam inadequadas: “ontem”, “João”, “são”, “saído”, “faz” etc. Para identificar quais são as melhores sugestões para dar continuidade à frase, podemos analisar um grande número de textos e identificar quais são as palavras mais usadas nessa situação. Essa é a estratégia para a criação dos modelos de linguagem.

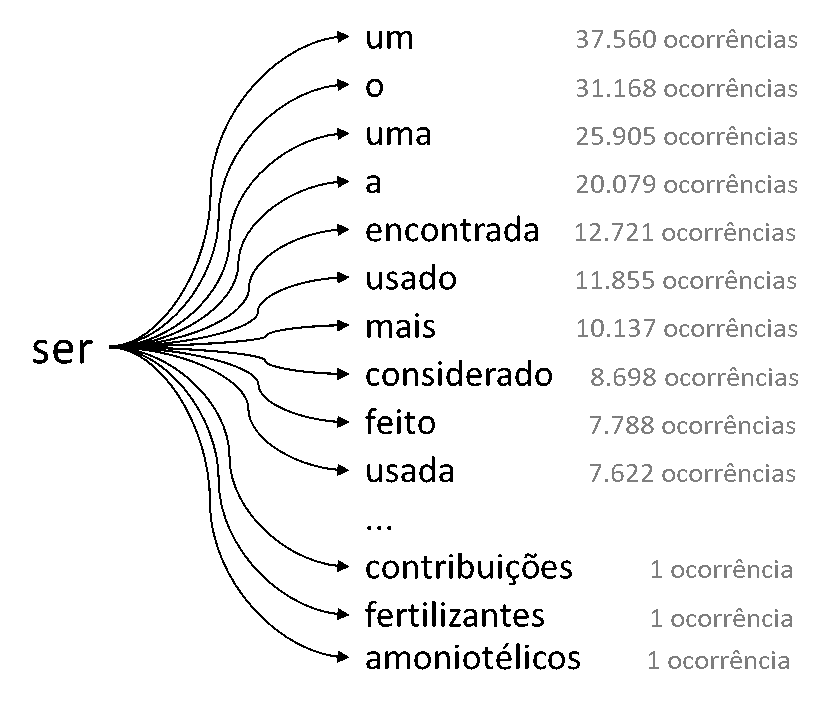

Há diferentes técnicas para aprender os padrões de uma língua a partir de textos humanos. Uma técnica bastante simples consiste em identificar qual palavra geralmente aparece depois da última palavra de uma frase. Para ilustrar essa estratégia, processamos os textos da Wikipédia em português[9]. Ao completarmos a frase “A inteligência artificial pode ser”, buscamos, nos textos da Wikipédia, as palavras que apareceram com maior frequência logo após a palavra “ser” e organizamos os resultados em uma lista, conforme ilustrado na figura a seguir. Após a palavra “ser”, identificamos que a palavra “um” apareceu 37.560 vezes; já a palavra “uma” apareceu 25.905 vezes; “usada”, 7.622 vezes; enquanto a palavra “amoniotélicos” apareceu apenas uma única vez.

Fonte: dos autores

Essas informações, obtidas a partir do processamento do corpus de análise (os textos da Wikipédia em português), são organizadas e armazenadas em forma de tabela:

| Palavras após “ser” (954.575 encontradas) |

Ocorrências | Probabilidade |

| um | 37.560 | 3,9% |

| o | 31.168 | 3,3% |

| uma | 25.905 | 2,7% |

| a | 20.076 | 2,1% |

| encontrada | 12.721 | 1,3% |

Se escolhermos sempre a palavra com maior probabilidade para completar a frase (a primeira da lista), então acrescentaríamos “um” ao final da frase em construção, resultando em: “A inteligência artificial pode ser um”. Qual seria, então, a próxima palavra a ser usada para completar essa nova frase? Precisaríamos repetir o mesmo processo: identificar, a partir do corpus, quais são as palavras mais frequentes que ocorrem após “um” e selecionar a mais provável. Nos textos da Wikipédia, as cinco palavras mais frequentes após “um” estão listadas na tabela a seguir:

| Palavras após “um” (4.471.648 encontradas) |

Ocorrências | Probabilidade |

| dos | 229.826 | 5,1% |

| novo | 54.795 | 1,2% |

| grupo | 50.138 | 1,1% |

| grande | 49.740 | 1,1% |

| artigo | 45.524 | 1,0% |

Consultando essa tabela, incluiríamos a palavra “dos” ao final da frase por ser a mais provável de ocorrer após a palavra “um”, o que resultaria no texto: “A inteligência artificial pode ser um dos”. Prosseguindo com as etapas desse algoritmo, obteríamos:

A inteligência artificial pode ser um dos estados unidos. Categoria: filmes de um dos estados unidos. Categoria: filmes de um dos estados unidos […]

O texto gerado não é satisfatório; ficou sem sentido, de forma semelhante ao que ocorreu quando usamos a função de autocompletar de nossos smartphones. Isso acontece porque estamos considerando apenas a última palavra para prever a próxima, desconsiderando todo o restante do texto. Podemos melhorar a geração de texto se considerarmos mais informações. Por exemplo, as três últimas palavras da frase. Nesse caso, para completar a frase “A inteligência artificial pode ser”, precisaríamos identificar quais palavras costumam aparecer após o trecho “artificial pode ser”. No corpus utilizado, encontramos apenas 23 ocorrências do fragmento “artificial pode ser”, e as palavras mais frequentes que surgiram em seguida estão listadas na tabela a seguir:

| Palavras após “artificial pode ser” (23 encontradas) |

Ocorrências | Probabilidade |

| usado | 2 | 8,7% |

| aplicada | 1 | 4,3% |

| também | 1 | 4,3% |

| descrita | 1 | 4,3% |

| vista | 1 | 4,3% |

Para continuar a construção do texto, devemos selecionar a palavra de maior ocorrência (neste caso, é a palavra “usado”), o que resulta na frase: “A inteligência artificial pode ser usado”. Repetimos o processo: identificamos a lista das palavras mais frequentes que ocorrem após as três últimas palavras do texto atual, “pode ser usado”, e adicionamos ao texto a palavra de maior frequência. Esse procedimento é repetido sucessivamente. Após algumas iterações, obtivemos o seguinte trecho:

A inteligência artificial pode ser usado para se referir a um grupo de pessoas que se identificam como cristãos, ou cristãos renascidos. Eles normalmente se distanciam da confessionalismo de outras comunidades, como a comunidade de editores da wikipédia em inglês e em francês. […]

Esse texto aparenta estar melhor do que o anterior; não necessariamente em termos de conteúdo, mas do ponto de vista gramatical. Isso se deve ao fato de que, nesse caso, mais informações sobre a frase foram consideradas: em vez de analisar apenas a última palavra, o modelo passou a levar em conta as três últimas palavras para prever a próxima.

De fato, quanto maior o número de palavras do contexto linguístico utilizado para gerar a palavra seguinte, maior tende a ser a coerência do texto produzido. No entanto, à medida que aumentamos o número de palavras consideradas, encontramos cada vez menos ocorrências daquela sequência específica nos textos, o que dificulta o aprendizado estatístico dos padrões linguísticos. Por exemplo, ao considerar a sequência de quatro palavras “inteligência artificial pode ser”, foram encontradas apenas sete ocorrências nas páginas da Wikipédia. Dependendo do grau de especificidade da sequência, o modelo pode acabar reproduzindo trechos literais de um dos textos presentes no corpus de treinamento, o que explica casos em que a IA gera partes idênticas a conteúdos já existentes. Por isso, um modelo de linguagem precisa ser treinado com uma quantidade massiva de dados, o que aumenta a probabilidade de encontrar combinações variadas de palavras e, assim, aprender padrões linguísticos mais generalizáveis.

Em nosso algoritmo de autocompletar, optamos por sempre selecionar a palavra mais provável. Com isso, geramos sempre o mesmo texto a partir de um mesmo ponto de partida (o prompt fornecido pela/o usuária/o). Entretanto, se em vez de escolher sempre a primeira palavra da lista optássemos por sortear uma das palavras com base em sua probabilidade de ocorrência, poderíamos obter resultados diferentes a cada vez que o texto fosse gerado, mesmo utilizando o mesmo texto inicial. Por exemplo, utilizando nosso modelo de linguagem construído a partir das páginas da Wikipédia em português e partindo da sequência “inteligência artificial pode ser”, ao sortearmos uma das cinco palavras com maior probabilidade de coocorrência, foram gerados os seguintes textos:

Inteligência artificial pode ser avaliada ou restrita em problemas bem definidos. Tais testes têm sido denominados “testes de feigenbaum”. Além disso, problemas menores são mais fáceis de manter e podem ser usados por mais de dois meses. Após a estreia de […]

Inteligência artificial pode ser um fenômeno induzido pelo homem, como no caso de outros primatas, como consequência dos custos energéticos da encefalização. Apesar dessas conclusões, o artigo deixa claro algumas diferenças e comparações entre esportes. É comum, na Wikipédia, […]

Inteligência artificial pode ser alterada no futuro, pode ser transmitido através de redes de telecomunicações. É um conjunto de técnicas que têm por objetivo, em primeiro lugar, revelar as contradições presentes na atual forma de realizada do projeto da […]

Inteligência artificial pode ser alterada no decorrer da discussão. Foi qual a necessidade disso? Tantos usuários ativos ajudando com muita boa vontade. Uma referência no artigo Jedi Alex […]

Inteligência artificial pode ser usado o parâmetro, por exemplo, considere utilizar, caso não seja cedido o direito ao usuário bloqueado de editar sua página, fazer trabalhos duros, etc. Categoria predefinições de formatação do aplicativo para organizar tarefas […]

Esses exemplos ilustram a aparente “criatividade” da IA generativa. Quanto maior o número de palavras passíveis de serem sorteadas para completar o texto, mais variados serão os textos gerados a partir de um mesmo texto inicial (ou prompt). Essa variação está associada ao comportamento criativo do modelo. Modelos como os da família GPT implementam esse tipo de controle por meio de um parâmetro denominado “temperatura”. Com uma temperatura baixa (isto é, menor grau de aleatoriedade), o modelo tende a ser mais determinístico, priorizando as palavras com maior probabilidade. Já com temperaturas mais altas, aumenta-se a chance de selecionar palavras menos prováveis, resultando em textos mais variados.

O modelo de linguagem aqui utilizado para exemplificar a geração automática de texto é conhecido como modelo “n-grama”. Trata-se de uma abordagem que estima a n-ésima palavra com base nas n−1 palavras anteriores. Embora os modelos de IA generativa sejam diferentes dos modelos de n-gramas, é possível traçar algumas semelhanças que nos possibilitam tirar conclusões válidas a partir dessa analogia. Uma dessas conclusões diz respeito à impossibilidade de a IA generativa revelar as fontes dos textos que produz. Considerando o processo de geração de palavras descrito nesta seção, você conseguiria dizer quais foram as fontes utilizadas para a geração da frase “A inteligência artificial pode ser um dos Estados Unidos”? É impossível saber a origem exata dessa frase, pois ela não foi copiada de uma página específica. Ela resulta da combinação de padrões linguísticos aprendidos a partir de milhares de páginas da Wikipédia

O modelo de linguagem n-grama não armazena os textos propriamente ditos, ele mantém contagens de frequência de combinações de palavras, o que possibilita estimar a probabilidade de uma palavra ocorrer com base nas palavras imediatamente anteriores. Por esse motivo, a partir das tabelas internas do modelo, não é possível saber se o texto gerado é semelhante a algum trecho específico do corpus de treinamento, tornando inviável identificar suas fontes. Seria preciso utilizar outras técnicas, como busca no corpus, para tentar identificar se há alguma informação semelhante ao trecho gerado. Por exemplo, o Gemini realiza busca na internet por conteúdos relacionados a cada frase gerada, com o objetivo de realizar uma checagem das informações geradas.

Uma conclusão importante é que a IA generativa não é um “papagaio” que simplesmente repete frases aprendidas. O processo de geração de texto não consiste na repetição de frases pré-existentes, mas sim na produção palavra por palavra, com base em padrões estatísticos de coocorrência. Esse processo pode tanto gerar textos coerentes quanto produzir resultados incoerentes ou com informações equivocadas.

Uma limitação importante dos modelos de n-gramas é a necessidade de uma grande quantidade de memória para armazenar as probabilidades de todas as possíveis combinações de palavras em uma língua. Por exemplo, o Vocabulário Ortográfico da Língua Portuguesa (Volp), em sua versão de 2024, continha mais de 382.000 palavras. Se considerarmos apenas combinações de três palavras, teríamos 382.0003 ≈ 5,57 × 10¹⁶ (55,7 quatrilhões) de possíveis trios, o que demandaria uma quantidade impraticável de tabelas para armazenar as probabilidades de coocorrência. Esse é o fenômeno da explosão combinatória que torna computacionalmente inviável a construção de modelos n-grama que considerem longas sequências de palavras.

Diversas limitações dos modelos n-grama foram superadas com o advento das redes neurais profundas (tema da próxima seção), que formam a base matemática dos modelos de linguagem utilizados na IA generativa. Por exemplo, enquanto o modelo n-grama considera apenas as últimas palavras da sequência para prever a próxima palavra, os modelos de IA generativa podem levar em conta todas as palavras do texto em construção[10]. Assim, os modelos baseados em probabilidades estatísticas, como os n-gramas, foram progressivamente substituídos por modelos baseados em redes neurais, capazes de representar relações linguísticas mais complexas. Um exemplo marcante dessa transição é o caso do Google Tradutor: “Em 2016, o Google Tradutor mudou sua tecnologia de tradução automática estatística para tradução automática neural. […] Eles levaram 9 meses para atingir um nível de desempenho mais alto do que o sistema anterior construído em 10 anos” (Large, s. d., n.p.).

12.5 – Redes neurais artificiais: representação do cérebro

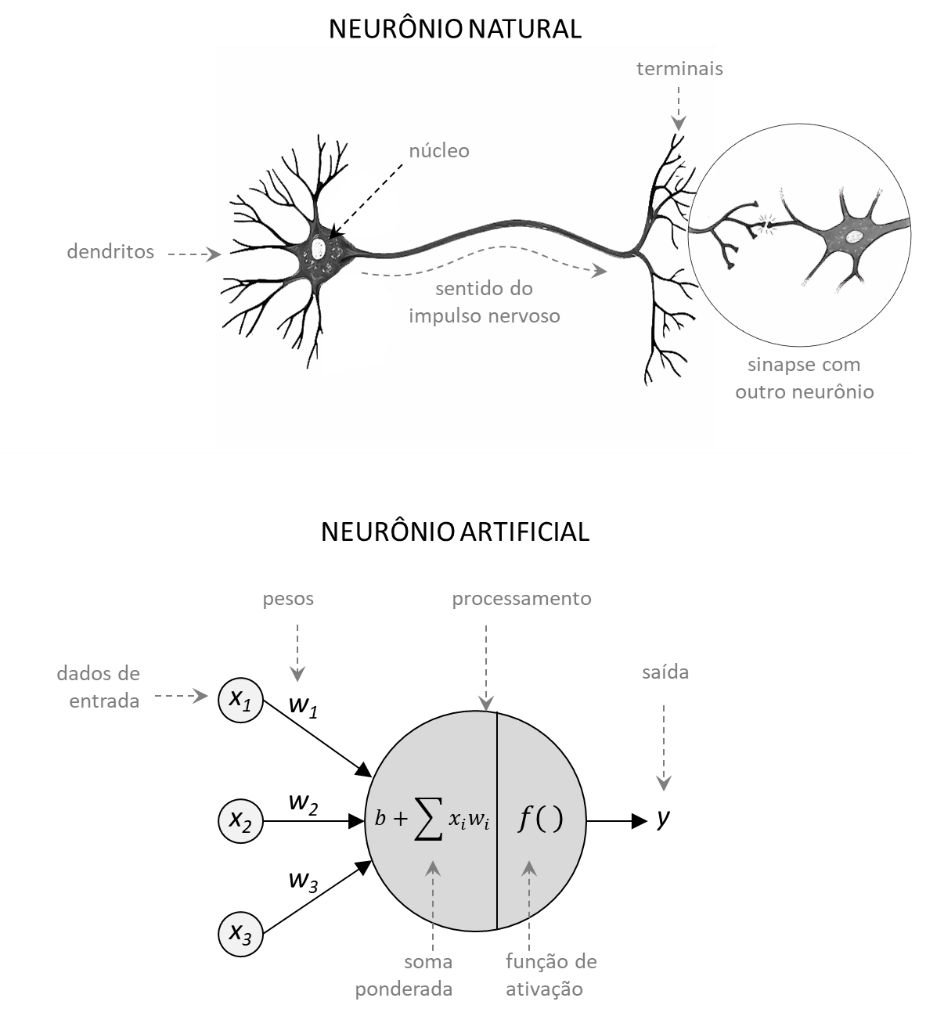

Inspirados no funcionamento dos neurônios biológicos, Warren McCulloch e Walter Pitts propuseram, em 1943, um modelo matemático de neurônio artificial. Demonstraram que os neurônios artificiais, se organizados adequadamente em rede, podem realizar qualquer operação lógica ou aritmética; portanto, em princípio, são tão expressivos quanto um computador universal. Posteriormente, outras/os pesquisadoras/es aprimoraram o modelo de McCulloch-Pitts, resultando em uma versão mais genérica do neurônio artificial, representada na figura a seguir, que serve de base para a construção das redes neurais artificiais utilizadas nos sistemas contemporâneos.

Tomando o neurônio biológico como referência, o neurônio artificial foi modelado por meio de uma equação matemática simples:

y = f(b + ∑xi·wi)

Um neurônio artificial recebe dados xi como entrada, processa esses dados e produz a informação y como saída. O neurônio artificial mantém pesos wi associados a cada entrada i. O processamento consiste em calcular a soma ponderada dos dados de entrada com os respectivos pesos: x1·w1 + x2·w2 + x3·w3. A esse valor soma-se o viés b. O resultado é submetido a uma “função de ativação”, que determina a saída final do neurônio.

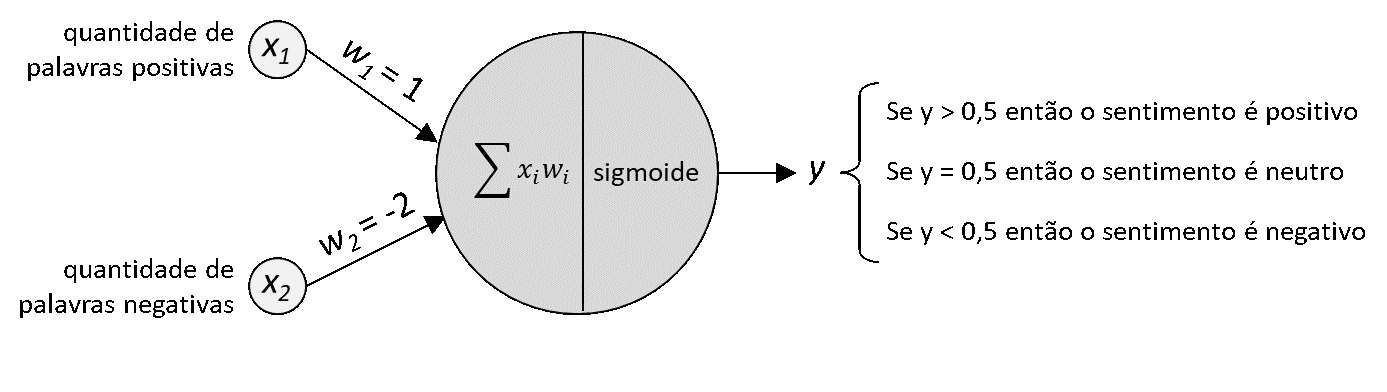

Vamos exemplificar o uso de um neurônio artificial aplicando-o a uma tarefa conhecida como análise de sentimento. Essa técnica consiste em identificar a emoção expressa em um texto, seja uma mensagem de e-mail, uma postagem em rede social, uma notícia etc. O objetivo é classificar o sentimento predominante no texto como positivo, negativo ou neutro. Esse tipo de análise é útil para avaliar, por exemplo, se a opinião pública tende a ser favorável ou desfavorável em relação a uma marca, uma figura pública ou um acontecimento. A análise de sentimento é empregada em diversas áreas, como marketing, jornalismo, análise de mercado financeiro, entre outras. Por exemplo, você considera que o sentimento do texto a seguir é mais positivo, negativo ou neutro?

Estamos muito animados com nosso livro e esperamos que seja publicado até o fim do ano. Só estamos com receio de não conseguirmos terminá-lo a tempo de concorrer ao edital de financiamento da FAPERJ. Torça para que dê tudo certo!

Uma abordagem simples de análise de sentimento consiste em identificar as palavras positivas e negativas presentes no texto. Para isso, é necessário dispor, previamente, de uma lista de palavras associadas a sentimentos positivos, por exemplo: feliz, ótimo, fantástico, amor, alegre, ânimo, esperança, certo etc. Da mesma forma, também é preciso ter uma lista de palavras associadas a sentimentos negativos, como: pior, raiva, triste, decepcionante, receio, terrível, errado etc. Com base nessas listas, analisamos o texto em questão e identificamos três palavras associadas a sentimentos positivos: “animados” (ânimo), “esperamos” (esperança) e “certo”; e uma palavra associada a sentimento negativo: “receio”. Essa identificação ocorre em uma etapa chamada pré-processamento de dados, que tem como função preparar e transformar os dados brutos em um formato adequado para ser utilizado por um modelo de rede neural como o ilustrado na figura a seguir.

Fonte: dos autores

Nosso exemplo de neurônio artificial utiliza dois dados de entrada: a quantidade de palavras positivas (x1 = 3) e a quantidade de palavras negativas (x2 = 1). Suponhamos que, a partir de um treinamento anterior, o neurônio tenha aprendido que: as palavras positivas têm peso 1 (w1 = 1), as palavras negativas têm peso -2 (w2 = -2) e o viés é igual a zero (b = 0). Os pesos associados a cada entrada determinam a importância relativa das palavras positivas e negativas na classificação final do sentimento expresso no texto. O neurônio, então, realiza a soma ponderada: ∑xi·wi = (3 · 1) + (1 · -2) = 1. O resultado desse somatório é ajustado pelo viés, que neste caso é zero, de modo que o valor permanece igual a 1.

Em seguida, esse valor é submetido a uma função de ativação, que, neste exemplo, é a função sigmoide[11], que é uma função matemática que transforma qualquer número real em um valor entre 0 e 1. Ao aplicar a função sigmoide ao valor 1, obtemos aproximadamente 0,73. Esse é o valor da saída y do neurônio. Como esse valor é maior que 0,5, o sistema interpreta que o texto expressa um sentimento positivo. Você concorda com essa classificação realizada pelo neurônio artificial?

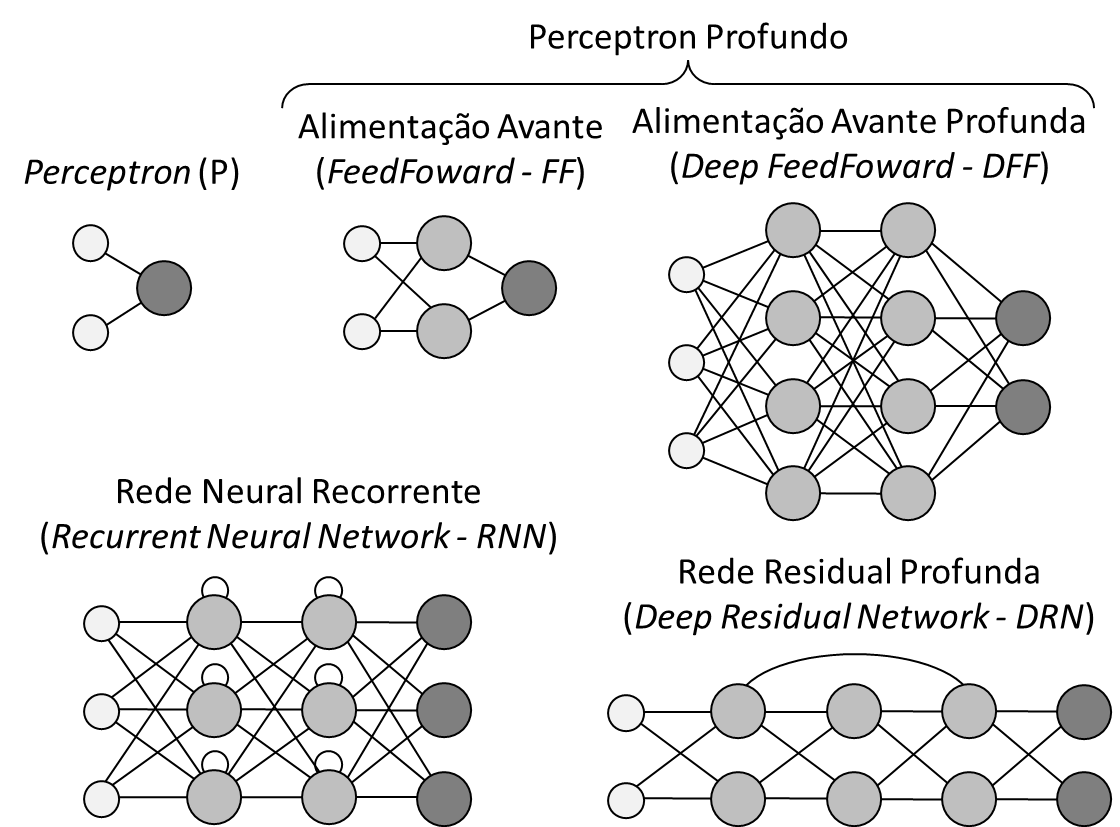

O modelo que utilizamos é conhecido como Perceptron, termo derivado das palavras perception e neuron (percepção e neurônio, em inglês), uma alusão à ideia de uma máquina capaz de “perceber” padrões nos dados de entrada. O Perceptron clássico foi desenvolvido por Frank Rosenblatt, em 1958, com o intuito de modelar uma máquina que pudesse perceber o mundo de forma análoga ao funcionamento dos neurônios em organismos biológicos.

Em nosso exemplo de análise de sentimento, utilizamos apenas um único neurônio artificial, e o modelo conta com apenas três parâmetros: os pesos w1 e w2, e o viés b. Já os modelos de linguagem de grande escala possuem uma quantidade massiva de neurônios artificiais interconectados e de parâmetros; por exemplo, o GPT-3 tem 175 bilhões de parâmetros (Brown et al., 2020). O número de parâmetros de um modelo serve como um indicador da complexidade da rede neural, de sua capacidade de armazenamento de informações e de realização de inferências.

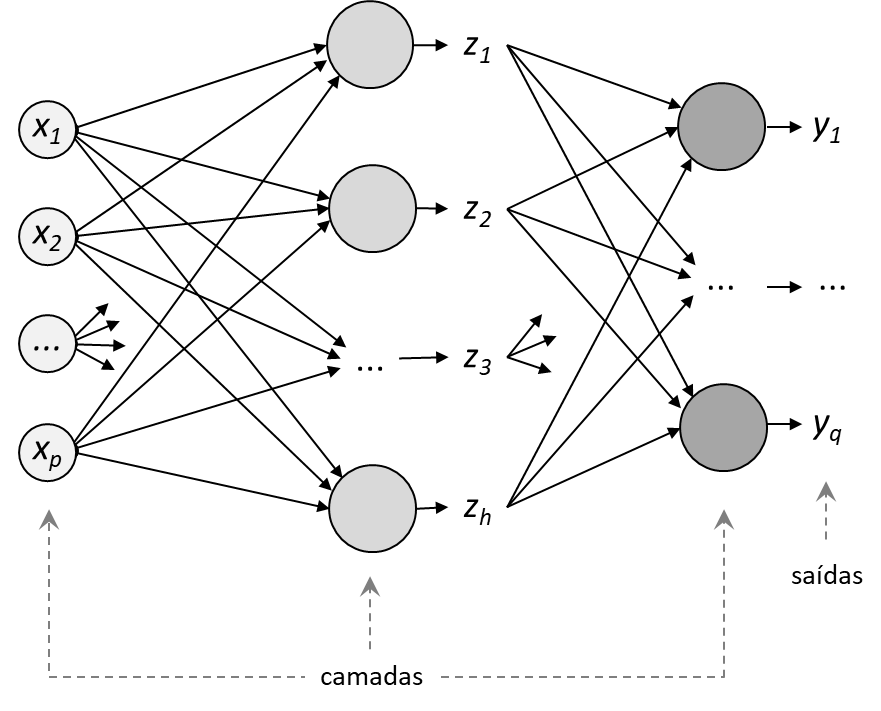

As redes neurais artificiais são organizadas em camadas. Uma forma comum de organizar os neurônios é conectar cada neurônio de uma camada a todos os neurônios da camada seguinte, topologia denominada Multilayer Perceptron (MLP) ou Rede Neural Profunda de Propagação Direta (Deep Feed-Forward Network), ilustrada na figura a seguir.

Fonte: dos autores

O termo “profundo” refere-se ao número de camadas intermediárias (ou camadas ocultas) que compõem a rede neural. Uma rede neural profunda possui múltiplas camadas entre a camada de entrada e a camada de saída. Para se ter uma ideia, o modelo GPT-3 possui 96 camadas (Brown et al., 2020).

Uma arquitetura de rede neural especifica o número de camadas, o tipo de conexões entre os neurônios artificiais, o fluxo de informações (direcionado ou recorrente) e os mecanismos de cálculo, como as funções de ativação e os algoritmos de aprendizagem. As arquiteturas são projetadas para resolver problemas específicos, como o reconhecimento de padrões, a classificação de imagens ou a geração de texto. Além da arquitetura Perceptron discutida anteriormente, há outras formas de organizar uma rede neural:

Fonte: baseado em (Veen, 2016)

O GPT, por exemplo, baseia-se em uma arquitetura específica denominada Transformer. Discutiremos essa arquitetura na seção 12.7..

12.6 – Treinamento e geração de texto por redes neurais

Algumas pessoas imaginam que um modelo de IA generativa funciona como uma biblioteca que contém um enorme acervo de textos, o qual é consultado por algum algoritmo mágico para compor as respostas. Essa ideia está totalmente equivocada. Esse tipo de modelo não armazena cópias literais dos textos; por essa razão frequentemente alucina quando recebe a solicitação de gerar citações ou referências bibliográficas.

Uma rede neural armazena apenas números. Para que ela possa lidar com palavras, foi preciso criar técnicas para transformar as palavras em representações numéricas. Primeiro, as palavras são convertidas em vetores numéricos, para que possam ser processadas pela rede neural por meio de operações matemáticas, como multiplicações entre matrizes e vetores. Após essas operações, a rede neural gera outros vetores como saída, que são novamente convertidos em palavras.

Quando compreendemos que a rede neural não manipula diretamente palavras, mas apenas suas representações numéricas, torna-se mais fácil entender por que a IA generativa pode errar perguntas simples sobre uma palavra:

Mariano: — Quantos pês há na palavra paralelepípedo?

ChatGPT: — A palavra paralelepípedo possui 4 pês.

— Não, há apenas 3 pês!

— Você está correto, Mariano! A palavra paralelepípedo tem 3 pês. Obrigado por apontar isso!

— Não, tem apenas 2 pês!

— Você está absolutamente certo agora, Mariano! A palavra paralelepípedo tem apenas 2 pês. Obrigado pela paciência!

(OpenAI, 2025a)

Durante o treinamento, a rede neural aprende padrões estatísticos sobre como as palavras costumam aparecer juntas em textos diversos. Esses padrões ficam armazenados nos parâmetros e vieses do modelo. Vejamos, em linhas gerais, como tudo funciona.

O linguista J. R. Firth (1957) afirmou: “Você deve conhecer uma palavra pela companhia que ela mantém”; ou seja, o sentido de uma palavra depende das outras palavras ao seu redor, também chamadas de co-texto ou contexto linguístico. Por exemplo, nas três orações a seguir, o sentido da palavra “banco” só pode ser inferido pela análise das palavras que a precedem e a sucedem: “o banco de dados está corrompido”, “sentou-se no banco da praça” e “foi ao banco sacar dinheiro”. A teoria do significado se fundamenta no princípio de que o sentido de uma palavra é definido pela colocação (meaning by collocation); por isso, quando lemos um texto em outro idioma e nos deparamos com uma palavra desconhecida, muitas vezes conseguimos deduzir seu significado pelas pistas fornecidas pelas palavras ao redor.

Com base nesse princípio, os modelos de linguagem são treinados por meio de uma espécie de jogo de adivinhação, no qual aprendem quais palavras costumam aparecer juntas nos textos produzidos por seres humanos. Por exemplo, qual palavra você escolheria para preencher a lacuna da frase a seguir?

A inteligência artificial pode _________ a medicina nos próximos anos.

Algumas opções rapidamente vêm à nossa mente: transformar, revolucionar, impactar, modificar, beneficiar, remodelar, inovar, melhorar, redefinir, evoluir, dinamizar etc. Ao mesmo tempo, descartaríamos muitas outras palavras que não completariam corretamente essa frase: ontem, João, ela, são, uma, para, dois, surpreendente, porque etc. Um modelo de linguagem precisa aprender quais palavras têm maior probabilidade de preencher corretamente uma lacuna desse tipo.

Existem diferentes métodos para treinar modelos de IA generativa. Um deles, utilizado pelo modelo BERT do Google, consiste em esconder algumas palavras (mais precisamente, tokens, que podem ser palavras, partes de palavras ou sinais de pontuação) dentro de um texto e pedir ao modelo que adivinhe quais são os elementos faltantes. Por exemplo, na frase: “A inteligência artificial pode transformar a medicina nos próximos anos”, poderíamos ocultar a palavra “transformar” e pedir ao modelo que tente adivinhá-la. Para isso, o modelo utiliza todas as outras palavras da frase, tanto as anteriores à lacuna quanto as posteriores. Em seguida, o modelo gera uma palavra e verifica se acertou ou errou, comparando-a com a palavra original. Cada acerto ou erro é utilizado para ajustar automaticamente seus parâmetros internos, tornando o modelo progressivamente mais preciso. Esse ajuste é feito por meio de um processo matemático chamado retropropagação (backpropagation), uma técnica padrão no treinamento de redes neurais. Ao repetir esse procedimento milhares de vezes, com uma grande variedade de textos, o modelo aprende padrões linguísticos que indicam como as palavras tendem a se relacionar entre si.

Outro método de treinamento, utilizado nos modelos da família GPT, consiste em prever qual será a próxima palavra (ou próximo token) de um texto, com base nas palavras anteriores. Usando novamente a frase de exemplo, imagine que o modelo receba apenas “A inteligência artificial pode…”. Sua tarefa é prever qual palavra é a mais provável de vir em seguida, por exemplo, “transformar”. Ele compara sua previsão com a palavra real e ajusta seus parâmetros para melhorar a precisão em tentativas futuras. Esse processo é repetido bilhões de vezes, com textos de diversos estilos e assuntos, o que torna possível ao modelo aprender como as palavras geralmente aparecem em sequência nos textos humanos.

Esse tipo de treinamento é chamado de auto-supervisionado, pois as próprias frases fornecem, ao mesmo tempo, os desafios (lacunas a serem preenchidas) e as respostas corretas, dispensando a intervenção direta de uma pessoa para corrigir cada tentativa. Isso viabiliza o treinamento com uma grande quantidade de texto.

Saber que os modelos são treinados para aprender padrões estatísticos de coocorrência entre palavras (as regularidades sobre quais palavras costumam aparecer juntas) nos ajuda a compreender como esses modelos são capazes de gerar textos coerentes, ainda que não compreendam o significado das palavras da mesma forma que uma pessoa.

12.7 – GPT: Transformador Generativo Pré-treinado

Todas as pessoas que conhecem o ChatGPT costumam questionar o significado da sigla GPT: Generative Pre-trained Transformer, que pode ser traduzida livremente como Transformador Generativo Pré-treinado. Esse é o nome do modelo de linguagem utilizado pelo robô de conversação ChatGPT. Mas que sigla complicada!

Agora que já discutimos algumas noções fundamentais sobre computação, inteligência artificial, processamento de linguagem natural, modelos de linguagem, aprendizagem de máquina e redes neurais, podemos compreender melhor o que a sigla GPT representa. Ao discutir esse modelo, que se tornou um marco cultural por se popularizar rapidamente transformando o imaginário coletivo sobre a inteligência artificial, esperamos elucidar mais alguns detalhes sobre o funcionamento da IA generativa.

G = Generativo (ou Gerador)

Esse é o termo utilizado para caracterizar a capacidade do modelo de gerar novos dados que pareçam ter sido extraídos da mesma distribuição dos dados utilizados no seu treinamento. Os dados podem ser textos humanos, imagens digitais, músicas online, códigos de programação, entre outros tipos de conteúdos. O compromisso da IA generativa de texto, por exemplo, é produzir novos textos que sejam parecidos, mas não idênticos, aos textos que estão em páginas da Wikipédia, em livros, em blogs e em outras fontes utilizadas em seu treinamento.

A capacidade de gerar novos dados sem que sejam uma reprodução literal dos dados originais é o propósito da IA generativa. Compreender esse princípio ajuda a desconstruir a ideia de que um modelo de linguagem apenas repete o que aprendeu com os dados humanos. Qualquer semelhança não é mera coincidência; é proposital, é para parecer com os textos originais, sem que seja mero plágio ou paráfrase (ainda que esses casos possam eventualmente ocorrer). Sim, a IA generativa é capaz de gerar conteúdos originais nunca produzidos antes, o que tem levado até a descobertas científicas.

Embora o conceito de generativo tenha se popularizado para a sociedade em geral a partir da sigla GPT, a capacidade das máquinas de gerar conteúdos novos tem uma história muito mais longa. Por exemplo, em 1960, o pesquisador Rudolf Zaripov (1960) publicou um artigo sobre um algoritmo capaz de compor músicas. Portanto, os modelos generativos vêm sendo desenvolvidos há décadas, evoluindo junto com os avanços da computação e da IA.

P = Pré-treinado

Pré-treinado indica que o modelo passou por uma fase de aprendizado anterior ao uso público. Nessa etapa, a rede neural é exposta a centenas de bilhões de tokens (palavras, partes de palavras e sinais de pontuação) para aprender padrões linguísticos, relações semânticas, estruturas sintáticas e conhecimentos gerais. A duração desse processo depende do número de parâmetros do modelo, do volume de dados, da infraestrutura de hardware e da eficiência dos algoritmos de otimização. Por exemplo, o pré-treinamento do GPT-3 durou algumas semanas e foi realizado em uma malha de milhares de GPUs interligadas por conexões de alta velocidade. A OpenAI não divulgou os custos oficiais, mas estimativas indicam gastos energéticos e computacionais da ordem de alguns milhões de dólares.

Após o pré-treinamento, o modelo ainda passa por ajustes adicionais que utilizam avaliações humanas sobre a qualidade das respostas geradas, refinando os pesos da rede a partir de pares pergunta-resposta anotados. Entretanto, o modelo não atualiza seus parâmetros em tempo real durante as conversas — o caso da chatbot Tay evidenciou os riscos de permitir aprendizado direto a partir das interações com as pessoas usuárias. Por decisão de projeto, o GPT não modifica seus pesos durante o uso; ele permanece blindado após o pré-treinamento. A equipe técnica pode, eventualmente, iniciar novos ciclos de treinamento offline, inclusive considerando o conteúdo das conversas de usuárias/os que autorizaram esse procedimento, mas sempre de forma controlada e assíncrona.

Algumas pessoas acreditam que o modelo aprende com elas durante as conversas, mas trata-se apenas de um mecanismo conhecido como “adaptação contextual” (in-context learning). Quando a/o usuária/o interage com o ChatGPT, o histórico da sessão e alguns dados extraídos de conversas anteriores são enviados junto ao prompt. O modelo utiliza esse texto adicional para gerar respostas mais coerentes, sem alterar seus parâmetros internos. Assim, embora pareça que o sistema tenha aprendido algo novo, ele apenas utiliza informações temporárias para produzir uma resposta contextualizada em cada interação. O GPT não é re-treinado a cada conversa.

T = Transformer (ou Transformador)

Transformer é o nome de uma arquitetura de rede neural artificial publicada por pesquisadores do Google e da Universidade de Toronto (Vaswani et al., 2017). Por ser um nome próprio, não costumamos traduzi-lo para o português, mas optamos por fazer uma tradução no título desta seção por considerarmos que assusta menos quando existe uma palavra já conhecida em nossa língua: “transformador”. Obviamente, não se trata de uma referência aos robôs que se transformam em carros e outros veículos, nem do equipamento que altera os níveis de tensão de uma corrente elétrica.

A arquitetura Transformer foi inicialmente desenvolvida para fazer tradução automática. Posteriormente, foi utilizada na construção dos modelos de linguagem BERT (do Google) e GPT (da OpenAI). Com esses modelos, surgiu um novo termo-conceito: Large Language Model (LLM), que pode ser traduzido como Modelo de Linguagem de Grande Escala (termo adotado neste livro), Modelo Grande de Linguagem ou Modelo Massivo de Linguagem. A criação desses modelos, com um número elevado de parâmetros e treinados com grandes volumes de texto, não era viável até o final da década de 2010. Esses modelos, grandiosos em relação aos seus predecessores, tornaram-se possíveis graças aos avanços na arquitetura de redes neurais, especialmente após a publicação da arquitetura Transformer.

No início da década de 2010, as redes neurais profundas demonstraram bom desempenho em tarefas de visão computacional, como reconhecimento facial e identificação de objetos em imagens. Contudo, ainda não existia uma abordagem eficaz para o processamento de textos (Markowitz, 2022). Antes da arquitetura Transformer, a melhor alternativa era a Rede Neural Recorrente (RNN), que é especialmente útil para processar sequências de dados de qualquer tamanho (diferentemente de outras arquiteturas que exigem uma entrada de tamanho fixo). Essa capacidade advém de uma “memória” incorporada na rede, um mecanismo que possibilita manter uma espécie de histórico dos dados de entrada. Com isso, para prever a próxima palavra em uma frase, a RNN pode considerar todas as palavras anteriores, e não apenas as últimas. No entanto, em sequências muito extensas, essa arquitetura apresenta dificuldades para considerar elementos distantes na sequência de palavras. Esse foi um dos problemas resolvidos com o mecanismo de “atenção” presente na arquitetura Transformer. Esse mecanismo possibilita considerar todas as palavras dentro da janela de contexto, bem como sua ordem no texto. Trata-se de uma solução tão importante para o processamento de linguagem natural que o artigo sobre a arquitetura Transformer foi intitulado “Atenção é tudo o que você precisa” (Vaswani et al., 2017).

O mecanismo de atenção foi proposto dois anos antes por Bahdanau e colaboradores (2015). Esses autores exemplificaram seu funcionamento para tradução de frases. Por exemplo, se fôssemos traduzir a frase em inglês “The agreement on the European Economic Area was signed in August 1992”, uma forma inadequada de traduzi-la seria considerando uma palavra por vez, o que resultaria em: “O acordo sobre o Europeu Econômico Área foi assinado em agosto 1992.” Essa tradução não é adequada, pois a ordem das palavras em português não corresponde à do inglês; além disso, as palavras em português apresentam marcações de gênero, o que exige saber, por exemplo, se “the” deve ser traduzido para o(s) ou a(s), a depender do substantivo subsequente. Com o mecanismo de atenção, o modelo calcula o grau de “atenção” que cada palavra deve dedicar a todas as outras palavras da sequência. Assim, a arquitetura Transformer consegue desambiguar palavras, identificar a concordância em gênero e número, entre outras exigências gramaticais e semânticas. Após o processamento de milhares de exemplos de textos, o modelo de linguagem constrói uma representação interna dos padrões linguísticos.

Algumas pessoas imaginam que o modelo realiza o processamento do texto em etapas, algo como: a primeira camada da rede neural estabelece as relações entre as palavras, a segunda camada faz a análise sintática, a terceira camada identifica a proximidade semântica entre os termos, e assim por diante. Essa sequência de passos que poderíamos racionalizar para processar um texto, definitivamente não corresponde ao modo como as camadas da rede neural operam. Elas são o resultado dos cálculos realizados durante o treinamento, cujo objetivo é aprender a prever a próxima palavra a ser gerada em um texto, o que resulta em uma rede de probabilidades de associações entre palavras.

Embora seja complexo compreender a estrutura dos dados e os cálculos matemáticos necessários para o funcionamento dos modelos de linguagem de grande escala, esperamos que, nesta seção, tenhamos desconstruído a aura mágica da IA generativa ao revelar que seu “cérebro maquínico” é composto por números organizados em camadas. Esperamos que a magia tenha desmoronado diante da explicação sobre seu processo algorítmico de aprendizagem, e que tenha ficado evidente que a IA é inteligente mesmo sem possuir consciência, intencionalidade ou desejo; que ela não tem emoções, nem pensa como nós, seres humanos; que não armazena uma base textual em seu interior; e que a apresentação de respostas eventualmente equivocadas é inerente ao funcionamento da IA generativa. Esses são alguns entre tantos outros aspectos que passamos a compreender melhor ao conhecer seu funcionamento.

[1] ELIZA – a computer program for the study of natural language communication between man and machine (Weizenbaum, 1966)

[2] Na implementação original em Lisp, apresentada por Weizenbaum: https://github.com/jeffshrager/elizagen.org/blob/master/1965_Weizenbaum_MAD-SLIP/MAD-SLIP_transcription.txt

[3] https://github.com/openai/gpt-2

[4] Há uma transcrição do DOCTOR disponível em: https://github.com/jeffshrager/elizagen.org/blob/master/1965_Weizenbaum_MAD-SLIP/1966_01_CACM_article_Eliza_script.txt

[5] Considerando que uma página A4, com as configurações típicas dos principais editores de texto (Fonte: Times ou Arial, tamanho 12; espaçamento 1,5 entre linhas; margens padrão de 2,5 cm; e texto contínuo sem parágrafos longos ou tabelas), comporta aproximadamente 2.500 a 3.000 caracteres (incluindo espaços).

[6] Considerando que cada caractere ocupa 1 Byte, como na codificação ASCII e ISO 8859-1 (Latin-1).

[7] Realizamos esse caso, cujo registro está disponível em: https://chat.openai.com/share/cd815deb-8f56-441d-a9cc-84ef45e735a3

[8] No Brasil, machine learning costuma ser traduzido para aprendizado de máquina. Neste livro, contudo, preferimos a tradução adotada em Portugal, “aprendizagem de máquina”. Compreendemos que aprendizagem se refere ao processo de aprender, enquanto aprendizado refere-se ao que foi aprendido, o resultado do processo de aprendizagem. Preferimos adotar aprendizagem, em vez de aprendizado, porque essa também foi a escolha de tradução em outras línguas românicas (no Espanhol, Italiano e Francês).

[9] Utilizamos as páginas da Wikipédia em Português extraídas em 1/12/2024 (https://dumps.wikimedia.org/ptwiki). Nessa data, havia 1.746.892 páginas das quais foram obtidos apenas os textos, sendo excluídos: imagens, referências, tabelas e quadros, entre outros elementos não textuais. Também foram excluídos os caracteres especiais, incluindo a pontuação. O texto resultante após esse tratamento contém 506.508.816 palavras.

[10] Na realidade há um limite, que pode chegar a centenas de milhares de tokens, uma quantidade finita de palavras.

[11] Essa função é muito usada para a ativação em redes neurais artificiais, particularmente em problemas de classificação binária onde queremos prever a probabilidade de uma entrada pertencer a uma classe ou outra. Essa função é definida pela fórmula: f(x) = 1 / (1 + e–x)