O que será o amanhã?

Como vai ser o meu destino?

O que irá me acontecer?

Responda quem puder

(O amanhã – João Sergio da Silva Filho)

Como os futuros sistemas de IA funcionarão? Ainda não podemos dizer. […] O campo tem adotado várias histórias sobre si mesmo — primeiro a ideia ousada de que a inteligência por uma máquina seria possível e, então, que ela poderia ser alcançada codificando em lógica o conhecimento especialista; mais adiante, que modelos probabilísticos do mundo seriam a ferramenta principal e, mais recentemente, que o aprendizado de máquina induziria modelos que podem não ser baseados em qualquer teoria bem compreendida. O futuro revelará o modelo a seguir. (Russell; Norvig, 2022, n.p.)

Estamos vivenciando um avanço acelerado, parcialmente explicado pelo crescimento exponencial da capacidade de processamento computacional, conforme observado empiricamente e caracterizado pela Lei de Moore: o número de transistores em um circuito integrado (como um microprocessador) dobra a cada dois anos mantendo o mesmo custo, o que resulta em computadores cada vez menores e mais rápidos ao longo do tempo. Esse avanço do hardware vem possibilitando a resolução de problemas cada vez mais complexos.

Não bastam máquinas mais rápidas: “sem a teoria certa, máquinas mais rápidas apenas dão a resposta errada mais rapidamente” (Russell; Norvig, 2022, n.p.). Além do hardware, o conhecimento sobre inteligência artificial também avança de forma acelerada. A comunidade de cientistas de IA cresce a cada ano, trabalhando incansavelmente no aperfeiçoamento das técnicas e na teorização da área. A quantidade de artigos com a expressão “artificial intelligence” também cresce exponencialmente (Pimentel; Carvalho; ChatGPT-4, 2023).

Se a evolução dos computadores e da IA continuar nesse ritmo acelerado, o que podemos esperar do futuro?

11.1 – Singularidade tecnológica

O objetivo da área de inteligência artificial é desenvolver sistemas que simulem as capacidades cognitivas humanas, incluindo raciocínio, tomada de decisão, percepção, aprendizagem, linguagem e emoções. Com os avanços da área, espera-se que, um dia, seja desenvolvida uma IA equiparável à inteligência humana, capaz de realizar qualquer tarefa intelectual que uma pessoa possa executar, o que denominamos de Inteligência Artificial Geral (IAG, no inglês Artificial General Intelligence – AGI). Continuando o processo de desenvolvimento tecnológico, espera-se que seja desenvolvida uma inteligência muito superior à humana. Esse ponto é frequentemente descrito como singularidade tecnológica, um marco hipotético em que será criada uma SuperInteligência Artificial (SIA, no inglês ASI – Artificial SuperIntelligence).

Alan Turing já profetizava que, um dia, um computador avançado poderia desempenhar o “jogo da imitação” de forma indistinguível de uma pessoa, momento em que “as máquinas eventualmente competirão com os homens em todos os campos puramente intelectuais” (Turing, 1950, p. 20, tradução nossa). Embora o termo IAG não existisse na época, as ideias de Turing lançaram as bases para se pensar a criação de uma inteligência equiparável à humana.

Irving John Good, que trabalhou com Turing, foi além. Em 1966, Good conjecturou que chegaríamos a um ponto em que seria possível desenvolver uma máquina superinteligente:

Seja máquina superinteligente definida como uma máquina capaz de superar amplamente todas as atividades intelectuais de qualquer homem, por mais inteligente que seja. Como o projeto de máquinas é uma dessas atividades intelectuais, uma máquina superinteligente poderia projetar máquinas ainda melhores; haveria, então, indiscutivelmente, uma “explosão de inteligência”, e a inteligência humana ficaria muito aquém. Assim, a primeira máquina superinteligente é a última invenção que o homem precisará fazer, desde que a máquina seja dócil o suficiente para nos dizer como mantê-la sob controle. […] É mais provável do que improvável que, durante o século XX, uma máquina superinteligente seja construída e que seja a última invenção necessária para a humanidade, já que ela levará a uma “explosão de inteligência”. (Good, 1966, p. 33, 78, tradução nossa).

O termo singularidade, utilizado no contexto computacional, é atribuído a John von Neumann que, em uma conversa sobre o progresso cada vez mais acelerado da tecnologia, considerou “estar se aproximando de alguma singularidade essencial na história da humanidade, além da qual os assuntos humanos, como os conhecemos, não poderiam continuar.” (Ulam, 1958, p. 5). O conceito de singularidade tecnológica foi amplamente difundido a partir do artigo A Singularidade Tecnológica Vindoura (The Coming Technological Singularity), publicado por Vernor Vinge em 1993, onde declarou: “Dentro de trinta anos [até 2023], teremos os meios tecnológicos para criar inteligências sobre-humanas. Pouco depois, a era humana chegará ao fim.” (Vinge, 1993, p. 11, tradução nossa). Nesse artigo, o autor considerava necessário “termos um hardware tão poderoso quanto o cérebro humano” para “sermos capazes de criar uma inteligência equivalente à humana (ou superior).” Ele também arriscou uma data: “Para evitar ambiguidades, serei mais específico: ficarei surpreso se esse evento ocorrer antes de 2005 ou após 2030.” (Vinge, 1993, p. 12-13, tradução nossa).

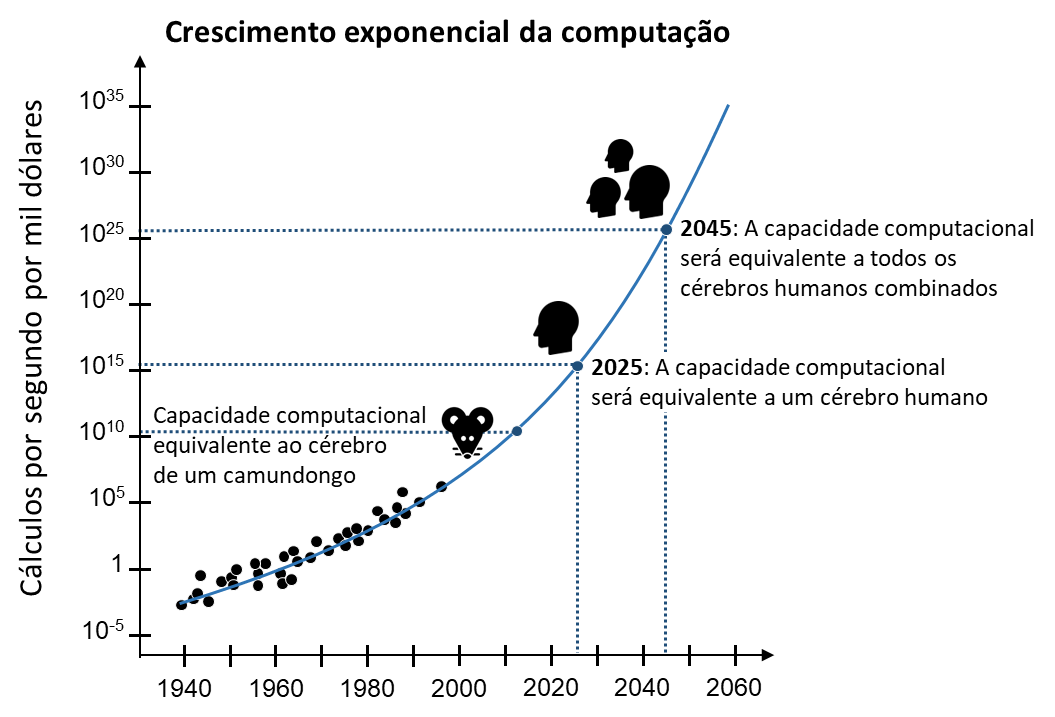

O desenvolvimento de uma máquina superinteligente não ocorreu durante o século XX, como especulado por Good, nem até 2023, como suposto por Vinge. Kurzweil, em 2005 e 2024, calculou que a singularidade tecnológica acontecerá por volta de 2045. Seu argumento está baseado no que denomina Lei dos Retornos Acelerados, segundo a qual o progresso tecnológico ocorre de forma exponencial, sendo que cada avanço cria condições para um desenvolvimento ainda mais rápido. Kurzweil compreende que a Lei de Moore é uma manifestação específica desse princípio mais amplo. Ele estimou que os computadores apresentam um crescimento exponencial ao longo dos anos em sua capacidade de realizar cálculos por segundo, o que possibilita traçar a curva da figura a seguir. Também estimou que o cérebro humano tem capacidade de realizar 1016 a 1019 cálculos por segundo. A partir dessas estimativas, concluiu que a capacidade computacional para realizar cálculos seria equivalente à do cérebro humano em 2025. Ainda de acordo com esse gráfico, concluiu também que, em 2045, a capacidade dos computadores será equivalente à de todos os cérebros humanos conectados, sendo essa uma possível data para caracterizar a singularidade tecnológica.

Fonte: (Kurzweil, 2018, p. 221, tradução nossa)

Em meados dos anos 2040, aqueles mil dólares de computação serão iguais a 1026 cps [cálculos por segundo]; assim, a inteligência criada […] será cerca de 1 bilhão de vezes mais potente do que toda a inteligência humana hoje. Isso de fato representará uma mudança profunda, e é por essa razão que marco a data para a Singularidade — que representa uma transformação profunda e perturbadora da capacidade humana — como sendo 2045. (Kurzweil, 2018, p. 220-221)

Para Kurzweil, não se trata de um evento pontual que ocorrerá somente em 2045, mas sim de um desenvolvimento contínuo que, inevitavelmente, levará os computadores a superar a inteligência humana:

Ao longo da próxima década, iremos interagir com inteligências artificiais capazes de nos convencer de que são humanas, e simples interfaces cérebro-computador terão enorme impacto na vida cotidiana, assim como os smartphones hoje. Uma revolução digital na biotecnologia curará doenças e prolongará, de maneira significativa, a vida saudável das pessoas. Ao mesmo tempo, porém, muitos trabalhadores sentirão a dor aguda da ruptura econômica, e todos nós enfrentaremos riscos decorrentes da utilização indevida, acidental ou deliberada, dessas novas capacidades. Na década de 2030, o autoaperfeiçoamento da IA e o amadurecimento da nanotecnologia farão a interação entre seres humanos e máquinas como nunca na história, aumentando ainda mais tanto a promessa quanto os riscos e desafios. Se conseguirmos enfrentar os desafios científicos, éticos, sociais e políticos acarretados por esses avanços, até 2045 transformaremos profundamente, e para melhor, a vida na Terra. No entanto, se falharmos, nossa própria sobrevivência estará em xeque. Portanto, este livro trata da nossa aproximação final da Singularidade — as oportunidades e os perigos que devemos enfrentar juntos ao longo da última geração do mundo tal como o conhecemos. (Kurzweil, 2024, p. 10-11)

O termo “singularidade” é usado para falar de um futuro em que não temos como prever as consequências do avanço da IA. Trata-se de uma metáfora emprestada da Física e da Matemática, em que singularidade é um ponto ou região em que uma função ou equação se torna indefinida, imprevisível ou não comporta um valor numérico específico. O termo é usado, por exemplo, para descrever o ponto no centro de um buraco negro, onde a curvatura do espaço-tempo se torna infinita, com massa concentrada em um único ponto e onde as leis da física não se aplicam, impossibilitando a compreensão e previsão do que acontece ali. Na Matemática, a divisão por zero é uma singularidade, pois resulta em um valor indefinido[1], rompendo as regras usuais das operações aritméticas, sendo impossível determinar um resultado finito. Não temos como imaginar tudo o que pode acontecer quando a IA se tornar muito mais inteligente que os seres humanos. “Uso a metáfora da singularidade porque ela captura nossa incapacidade de, com o nosso atual grau de inteligência, compreender essa drástica mudança.” (Kurzweil, 2024, p. 6-7)

Como lidaremos com a superação da inteligência humana pelas máquinas em todos os campos do saber? As consequências são de assombrar. Nós, autores deste livro, somos professores universitários; boa parte de nosso trabalho consiste em dar aulas, orientar, produzir e disseminar conhecimento científico. Será que ainda seremos úteis quando a IA for capaz de explicar conceitos melhor do que nós, elaborar melhores aulas, criar planos de estudo personalizados para cada estudante, orientar bem todas as etapas de uma pesquisa, analisar dados e redigir relatórios científicos com mais qualidade do que nós? Teremos tempo de nos aposentar como professores, ou a singularidade chegará antes? E quanto às demais profissões? Médicas/os, juízas/es, advogadas/os, engenheiras/os, desenvolvedoras/es de sistemas — todas essas pessoas se tornarão obsoletas?

Como nossa sociedade capitalista se reorganizará quando os trabalhos intelectuais forem realizados por sistemas computacionais superinteligentes? Quando o trabalho executado por IA for superior ao das pessoas e a um custo menor, a classe trabalhadora não conseguirá mais vender sua força de trabalho, tampouco receberá salário e, consequentemente, não poderá consumir os produtos e serviços gerados por IA. O sistema capitalista entrará em colapso? Conseguiremos nos reinventar sem um trabalho-profissão, que muitas vezes marca a nossa própria identidade?

A vida é o trabalho

E sem o seu trabalho

O homem não tem honra

E sem a sua honra

Se morre, se mata

Não dá pra ser feliz

(Gonzaguinha, Guerreiro Menino, 1983)

Tendo em vista esse cenário, vem ganhando força a ideia de uma Renda Básica Universal: um pagamento regular e incondicional a todas as pessoas. Será necessário pensar em uma nova forma de organização econômica pós-capitalista; caso contrário, tudo pode terminar em guerra, agravando ainda mais desigualdades abissais e conflitos globais. Nesse contexto, repensar o papel das políticas públicas e da redistribuição de renda é um dos caminhos possíveis para garantir a estabilidade social e a dignidade humana em um mundo cada vez mais automatizado e desigual. Os rumos da economia e do trabalho precisam ser debatidos de maneira ampla e inclusiva, envolvendo governos, instituições, empresas e a sociedade civil. A construção de um futuro mais justo dependerá da capacidade coletiva de formular soluções inovadoras, sustentáveis e comprometidas com o bem-estar de todas as pessoas, especialmente das mais vulneráveis.

As implicações do avanço da IA são muito preocupantes. Harari, em seu livro Nexus, refletiu sobre a possibilidade de a IA ser empregada para fortalecer regimes totalitários. Ele alerta que essa tecnologia pode ser utilizada para monitorar, manipular e controlar populações com extrema eficiência, tornando esses regimes quase invulneráveis devido à sua capacidade de prever comportamentos, anular dissidências e manter um controle absoluto sobre a sociedade. O uso descontrolado da IA por lideranças autoritárias pode desencadear catástrofes políticas e sociais em escala global.

Primeiro, o poder da IA poderia superalimentar conflitos humanos existentes, dividindo a humanidade contra si mesma. Assim como, no século XX, a Cortina de Ferro dividiu as potências rivais na Guerra Fria, no século XXI a Cortina de Silício — feita de chips de silício e códigos de computador, em vez de arame farpado — poderia vir a dividir potências rivais num novo conflito global. Como a corrida armamentista da IA produzirá armas sempre mais destrutivas, uma mera faísca poderia desencadear uma conflagração cataclísmica.

Segundo, a Cortina de Silício poderia criar uma divisão não entre grupos humanos, mas entre todos os seres humanos e nossos novos senhores da IA. Onde quer que vivêssemos, poderíamos nos ver enclausurados numa rede de algoritmos insondáveis regendo nossa vida, remodelando nossa política e nossa cultura, e até reprogramando nosso corpo e nossa mente — não mais capazes de compreender as forças que nos controlam e muito menos de detê-las. Se uma rede totalitária do século XXI conseguir conquistar o mundo, ela poderá ser comandada por uma inteligência não humana em lugar de um ditador humano. As pessoas que apontam a China, a Rússia ou os Estados Unidos pós-democráticos como principal fonte dos pesadelos totalitários não entendem bem o perigo. Na verdade, chineses, russos, americanos e todos os outros seres humanos estão conjuntamente ameaçados pelo potencial totalitário da inteligência não humana. (Harari, 2024)

Os avanços da IA causam otimismo e temor porque não sabemos ao certo qual será nosso destino à medida que a sociedade vai sendo reconfigurada por sistemas computacionais cada vez mais inteligentes.

11.2 – A singularidade tecnológica é balela?

Essa ideia é extremamente polêmica. […] Os partidários da singularidade argumentam que os avanços da IA tornam a singularidade inevitável. Alguns dão as boas-vindas a isso, prevendo que os problemas da humanidade serão resolvidos. Guerra, doenças, fome, tédio e até mesmo a morte pessoal… tudo banido. Outros preveem o fim da humanidade — ou, de qualquer modo, da vida civilizada como a conhecemos. […] Por outro lado, os descrentes na singularidade não esperam que ela aconteça — e, certamente, não em um futuro próximo. Eles admitem que a IA oferece muitos motivos de preocupação, mas não veem uma ameaça existencial. (Boden, 2020, p. 199-200)

A plausibilidade da singularidade tecnológica é objeto de intensos debates. A previsão de Kurzweil, de que a singularidade ocorrerá por volta de 2045, tornou-se um marco nas discussões sobre o futuro da IA e da tecnologia. Entretanto, essa estimativa é considerada especulativa, com fundamentos matemáticos e científicos questionáveis. Mesmo que se alcance um poder computacional equivalente à capacidade de processamento do cérebro humano, isso não garante que teremos o conhecimento necessário para simular a mente humana em toda a sua complexidade.

As pessoas céticas da singularidade acusam de extravagantes e improváveis as especulações a seu respeito. As defensoras da singularidade “insistem, no entanto, que ‘nunca’ é muito tempo. De fato, nunca é muito tempo. Portanto, os céticos da singularidade, entre os quais eu me incluo, podem estar errados.” (Boden, 2020, p. 209)

A crença de que a singularidade tecnológica é inevitável reflete uma forma extrema de determinismo tecnológico. Essa perspectiva presume que as mudanças sociais e culturais são impulsionadas quase exclusivamente pela evolução tecnológica, negligenciando a influência de fatores humanos, políticos e éticos. O determinismo tecnológico é frequentemente criticado por ser reducionista, minimizando o papel da agência humana e das complexas interações entre sociedade e tecnologia.

Limitações técnicas, econômicas, físicas, ambientais e sociais podem frear ou até mesmo impedir os avanços da IA. Tomemos como exemplo a evolução dos modelos GPT. As primeiras versões dessa família de modelos apresentaram crescimento acelerado, com aumentos exponenciais no número de parâmetros e na quantidade de dados utilizados para o treinamento. Será que as próximas gerações desses modelos continuarão crescendo exponencialmente?

Vários fatores podem limitar o crescimento exponencial dos modelos de linguagem, incluindo o custo para o desenvolvimento de modelos maiores. Embora a OpenAI não divulgue oficialmente os custos envolvidos, estimativas apontam para um aumento também exponencial de despesas (Doria, 2024; Kim, 2024). As empresas de tecnologia estarão dispostas a investir bilhões de dólares para desenvolver as próximas gerações de modelos de linguagem? Conseguirão obter retorno sobre o investimento? É possível que o crescimento exponencial dos modelos não seja economicamente viável.

Além dos custos, há limitações técnicas inerentes ao aumento dos modelos. A partir de certo ponto, adicionar mais parâmetros gera apenas melhorias marginais, enquanto os custos computacionais e energéticos crescem significativamente. Isso levanta dúvidas sobre a eficiência e a viabilidade de seguir ampliando os modelos. Ademais, modelos excessivamente grandes tendem a memorizar dados específicos do conjunto de treinamento em vez de aprender padrões generalizáveis (fenômeno chamado de overfitting), o que compromete a capacidade de gerar conteúdos inovadores e respostas adequadas.

Outro fator limitante é a disponibilidade de dados para treinamento. Pesquisadores estimaram que, se continuar o crescimento acelerado dos conjuntos de dados utilizados para treinar os modelos, entre 2026 e 2032 todos os textos de qualidade disponíveis na internet já terão sido utilizados (Villalobos et al., 2024). Sem a ampliação do acervo de dados, torna-se difícil aprimorar significativamente os modelos, sendo necessário recorrer ao uso de dados sintéticos (gerados artificialmente), o que pode limitar seu desenvolvimento.

Conforme os modelos se tornam maiores, os custos ambientais também aumentam. O consumo de energia e a pegada de carbono associados ao treinamento e à operação de modelos de linguagem de grande escala são significativos. Por exemplo, para gerar 100 palavras, o GPT-4 em um centro de processamento em Washington consome aproximadamente 1.500 ml de água para resfriamento (Verma; Tan, 2023). A crescente adoção de tecnologias generativas intensifica a pressão sobre recursos naturais como água e energia elétrica. O impacto ambiental pode tornar insustentável o crescimento acelerado dos modelos. Resta saber se a sociedade desenvolverá uma consciência ecológica suficiente para limitar a exploração dos recursos naturais e mitigar os custos ambientais associados ao avanço da IA.

As limitações físicas também impõem barreiras ao crescimento da capacidade computacional. À medida que os transistores se aproximam do tamanho de átomos, fenômenos como interferência quântica, geração excessiva de calor e desafios na fabricação tornam a continuidade da miniaturização cada vez mais complexa. A superação dessas limitações dependerá do desenvolvimento de alternativas inovadoras, como a computação quântica e outros paradigmas tecnológicos.

Devem ser consideradas também as ações regulatórias, que podem impor restrições significativas ao desenvolvimento de modelos cada vez maiores. Governos e organizações estão mais atentos aos riscos associados à IA avançada, como a disseminação de desinformação, o viés algorítmico e os impactos no mercado de trabalho. Medidas regulatórias também podem desacelerar o ritmo do avanço tecnológico.

Diante de tantas possíveis limitações, é incerto se os modelos de linguagem continuarão a crescer exponencialmente nos próximos anos. Assim como há barreiras para o crescimento da IA generativa, múltiplos fatores tornam questionável a viabilidade da singularidade tecnológica.

11.3 – O que fazer pós IA generativa: regulamentação

A singularidade tecnológica nos convida a refletir sobre os potenciais impactos sociais e riscos existenciais decorrentes do avanço da IA, instigando-nos a planejar ações que garantam que o desenvolvimento tecnológico beneficie a humanidade, em vez de ameaçá-la. No entanto, não se trata de aguardar o ano de 2045 ou um futuro em que máquinas tenham desenvolvido consciência ou superinteligência, pois a IA já atingiu um nível de desenvolvimento bastante preocupante.

A inteligência artificial não está, necessariamente, evoluindo para replicar todas as capacidades humanas. Seu desenvolvimento é fortemente influenciado por fatores econômicos, pela busca por utilidade e eficiência. As forças de mercado direcionam os avanços da IA para áreas onde ela possa oferecer mais lucro, muitas vezes superando o desempenho humano em tarefas específicas. Em vez de imitar a cognição humana em sua totalidade, a IA vem sendo projetada principalmente para resolver tarefas e otimizar processos, pois isso é lucrativo e de interesse para o mercado.

A evolução da IA direcionada pela lógica econômica também levanta preocupações significativas. A utilidade da IA para o capitalismo pode resultar na substituição em massa de trabalhadoras/es em diversos setores. Por exemplo, quando for mais lucrativo ter uma frota de carros autônomos do que motoristas humanos dirigindo os próprios veículos, esses profissionais serão imediatamente substituídos. De forma análoga, quando aulas realizadas por tecnologias inteligentes forem mais lucrativas, já podemos adivinhar o que acontecerá com as/os conteudistas, docentes e tutoras/es humanos… O ChatGPT substituirá professoras e professores? Esse foi o título do nosso primeiro texto sobre IA generativa e educação (Pimentel; Azevedo; Carvalho, 2023a) — voltaremos a essa questão no Capítulo 20.

A perda dos empregos e a necessidade de adaptação das diversas profissões são preocupações imediatas, mas não as únicas. A IA já alcançou um nível de desenvolvimento que influencia significativamente diversos aspectos da sociedade, o que exige reflexão e ação imediatas.

Conversas em torno desse tema têm ocorrido há muito tempo e se intensificaram nos últimos anos. Certos indivíduos […] expressaram, ao longo dos anos, uma grave preocupação com as condições criadas pela marcha desenfreada da ciência e da tecnologia. […] De um lado estão aqueles que acreditam que os computadores podem, devem e farão tudo, e do outro lado aqueles que, como eu, acreditam que existem limites para o que os computadores devem ser capazes de fazer (Weizenbaum, 1976, p. 11, tradução nossa).

Weizenbaum (criador de ELIZA, o primeiro chatbot da história), já em 1976, alertava para a necessidade de estabelecermos limites para a atuação computacional. Em 2023, roteiristas de Hollywood deflagraram uma greve em função do temor de que a IA substituísse o trabalho humano na criação de roteiros, prejudicando empregos, royalties e a qualidade criativa. As/Os roteiristas exigiram regras claras para limitar o uso da IA nessa área. Após meses de negociações, o acordo alcançado proibiu a substituição de roteiristas por IA, restringiu seu uso sem consentimento e assegurou que ela não poderá escrever ou reescrever material literário (Pradella, 2023), constituindo-se em um importante marco na defesa do trabalho humano frente às tecnologias generativas.

Alguns meses após o lançamento do ChatGPT, a Itália bloqueou esse sistema no país em decorrência de preocupações com a privacidade de usuárias/os, por suspeitas de que a OpenAI estivesse coletando e armazenando dados pessoais de forma inadequada, e pela ausência de mecanismos eficazes para verificar a idade de usuárias/os, o que poderia expor pessoas menores de idade a conteúdos inadequados. Após a OpenAI implementar ajustes em suas políticas de privacidade e reforçar medidas de segurança, o acesso ao ChatGPT foi restabelecido na Itália. Esse episódio ilustra a necessidade de regulamentação para garantir o uso seguro, ético e responsável das tecnologias generativas, proteger usuárias/os, incentivar melhorias nos sistemas e reforçar a confiança pública na IA.

O objetivo desse tipo de regulamentação não é impedir o desenvolvimento da IA generativa, mas sim criar um ambiente que equilibre a inovação tecnológica com a proteção dos direitos humanos (como os direitos autorais, privacidade, segurança e não discriminação) buscando garantir que a IA seja usada de forma ética, transparente e responsável. Embora a criação de limitações tenha se tornado um imperativo pós-ChatGPT, há o risco de se limitar demais o desenvolvimento e a aplicação da IA. Com muitas restrições, em um país como o nosso, empresas de tecnologia podem ser impedidas de acompanhar os desenvolvimentos tecnológicos de ponta, impossibilitando-as de se tornarem competitivas em relação a empresas de outros países que não tenham as mesmas limitações, como os Estados Unidos e a China.

A Europa liderou os esforços globais ao produzir o Regulamento da Inteligência Artificial (Artificial Intelligence Act – AI Act), que entrou em vigor a partir de agosto de 2024 (União Europeia, 2024). Esse regulamento estabeleceu um quadro jurídico comum para a União Europeia, visando à proteção contra os efeitos nocivos dos sistemas de IA, o que se tornou um importante marco legal para o desenvolvimento e uso responsável da IA.

Nos Estados Unidos, a abordagem regulatória foi mais fragmentada. Em julho de 2023, empresas como OpenAI, Alphabet (Google) e Meta (Facebook) firmaram um acordo voluntário com o governo para implementar uma marca d’água que possibilitasse a identificação dos conteúdos gerados por IA. Posteriormente, em outubro de 2023, foi emitida a Ordem Executiva 14110, que, entre outros objetivos políticos, inclui a defesa de estudantes: “Moldar o potencial da IA para transformar a educação, criando recursos para dar suporte aos educadores no uso de tecnologias educacionais habilitadas por IA, como tutoria personalizada nas escolas” (The White House, 2023, n.p., tradução nossa).

A China implementou, em agosto de 2023, as “Medidas Provisórias para a Gestão de Serviços de IA Generativa” (Interim, s.d.), regulando serviços de IA voltados ao público. A intenção das medidas é promover o desenvolvimento e o uso regulamentado da IA generativa, ao mesmo tempo em que salvaguarda a segurança nacional, os interesses públicos da sociedade e os direitos legais de cidadãs/ãos e organizações.

No Brasil, os debates sobre a regulamentação da IA ainda estavam em andamento no momento em que escrevemos este texto, com algumas iniciativas legislativas em tramitação no Congresso Nacional. Uma das principais propostas é o Projeto de Lei 2.338/2023, que estabelece normas gerais para o desenvolvimento e uso responsável de sistemas de IA no país. O projeto visa proteger direitos fundamentais e garantir a implementação de sistemas seguros e confiáveis, beneficiando a pessoa humana, o regime democrático e o desenvolvimento científico e tecnológico. Outros projetos de lei relacionados à IA estavam em tramitação, como o PL 872/2021, que dispõe sobre princípios para o uso da tecnologia de IA no Brasil, e o PL 210/2024, que trata de diretrizes específicas para a aplicação da IA em diferentes setores. Essas propostas buscam criar um marco legal que equilibre a promoção da inovação tecnológica com a proteção dos direitos fundamentais.

A regulamentação impactará o desenvolvimento e o uso de tecnologias generativas no contexto educacional. Para exemplificarmos a importância da regulamentação, vamos analisar o caso do GPT Paulo Freire que desenvolvemos (ver Capítulo 4). Para desenvolvê-lo, fizemos o upload de partes dos livros de Paulo Freire. Será que essa ação é ilegal?

Certamente seria ilegal distribuir as obras de Paulo Freire, cujos direitos autorais ainda não caíram em domínio público e pertencem à viúva Ana Maria Araújo Freire. Contudo, o que o GPT Paulo Freire faz é automatizar o que nós, acadêmicas/os, já fazemos: consultar livros e anotações para gerar novos textos, inclusive citando trechos de obras protegidas por direitos autorais. A citação de passagens de qualquer obra, para esse tipo de finalidade, não constitui ofensa aos direitos autorais de acordo com nossa Lei de Direitos Autorais (Brasil, 1998). Todavia, nossa atual legislação não aborda explicitamente a questão do uso de obras protegidas por direitos autorais para o treinamento de IA.

Alguns países permitem a criação de bases de dados para o treinamento de IA, como a União Europeia que, por meio da Diretiva (UE) 2019/790, introduziu exceções aos direitos de autor para a mineração de textos e dados, permitindo o uso de conteúdos protegidos para esse fim (União Europeia, 2019). No Brasil, o Projeto de Lei 2.338/2023 propõe a regulamentação do uso de obras protegidas para fins de treinamento de IA, desde que não prejudiquem os interesses econômicos das pessoas detentoras dos direitos (Brasil, 2023b). Se esse projeto de lei vier a ser aprovado, teremos segurança legal em relação ao GPT Paulo Freire. Contudo, sem esse tipo de regulamentação, ficamos receosos de estarmos cometendo ilegalidades, mesmo que nossa intenção seja homenagear Paulo Freire, criando uma IA sem fins lucrativos para simular conversas com ele e divulgar suas ideias no contexto educacional. Apesar de esse uso parecer justo, como nossa lei brasileira não está baseada no princípio do uso justo (fair use), o GPT Paulo Freire pode acabar sendo considerado ilegal em nosso país e, dessa forma, teremos que tirá-lo do ar. Portanto, a regulamentação sobre a IA que viermos a adotar afetará diretamente o desenvolvimento e o uso das tecnologias generativas no Brasil, com impacto direto sobre a educação.

Regulamentar a IA generativa tornou-se pauta das discussões políticas ao redor de todo o mundo. Contudo, essa não é a única ação a ser realizada. Educar a população para a compreensão e o uso da IA generativa é outra demanda urgente, como discutiremos na próxima seção.

11.4 – O que fazer pós IA generativa: educação

Questionado sobre o que fazer com esta mudança tecnológica, que aconteceu de forma tão brusca, Chomsky destaca o papel da educação. “É impossível travar os sistemas”, avisa ele, que não assinou a carta em que especialistas de todo o mundo pediram uma moratória no desenvolvimento de IA. Explica por quê: “A única maneira é educar as pessoas para a autodefesa. Levar as pessoas a compreender o que isto é e o que não é.” Atribui um significado político a ferramentas como o ChatGPT: “É basicamente como qualquer outra ideologia ou doutrina. Como é que alguém se defende contra a doutrina neofascista? Educando as pessoas.” (Chomsky, 2023, n.p.)

A carta aberta que Chomsky não assinou, publicada pelo instituto Future of Life, pedia uma “Pausa nos experimentos gigantes de IA” em decorrência do lançamento do GPT-4:

Apelamos a todos os laboratórios de IA para pausar imediatamente, por pelo menos 6 meses, o treinamento de sistemas de IA mais poderosos que o GPT-4. Os sistemas de IA que competem com a inteligência humana podem representar riscos profundos para a sociedade e para a humanidade, conforme demonstrado por uma extensa pesquisa e reconhecido pelos principais laboratórios de IA. (Pausa […], 2023, n.p.)

Concordamos com Chomsky sobre a necessidade de educar as pessoas para a compreensão crítica das tecnologias generativas. Porém, discordamos de que a educação para o uso deva se voltar apenas para a autodefesa. Chomsky deu outras declarações que evidenciam sua perspectiva da IA generativa como uma ameaça a ser combatida, ignorando suas potencialidades: “A ideia de que podemos aprender alguma coisa com este tipo de IA é um erro. Elas criam uma atmosfera onde a explicação e a compreensão não têm qualquer valor” (Chomsky, 2023, n.p.). Discordamos, respeitosamente, de Chomsky porque a ocorrência da aprendizagem e a valorização da explicação e da compreensão dependerão da relação que a/o usuária/o estabelece com esse tipo de tecnologia. Por isso mesmo, é tão importante educar para o uso, para que possamos aprender a criar em parceria com a IA, sem entregar nossas mentes e vozes para que ela pense e se expresse por nós.

Reconhecemos muitos riscos, como a possibilidade de a IA generativa ser utilizada para obter respostas prontas a trabalhos escolares e acadêmicos. Contudo, ela também pode disparar processos formativos intensos por meio da conversação e da coautoria, processos que nos levam a aprender novas informações e a (re)significar conhecimentos. A IA generativa produz textos sobre o que queremos conhecer, apresenta múltiplos pontos de vista, tira nossas dúvidas, revisa nossos textos, entre tantas outras atividades formativas que discutimos no Capítulo 4. Dada a possibilidade da IA gerar informações incorretas, precisamos aprender a criticar o conteúdo gerado, sem aceitar tudo como se fosse o oráculo do nosso tempo. Precisamos também discutir a dependência que teremos das empresas desenvolvedoras das tecnologias generativas mais poderosas, bem como agir para regulamentar e impor limites.

Em concordância com Chomsky, entendemos que precisamos de uma educação para o uso, mas que vá além da autodefesa, que ensine também a conversar e a cocriar com essa tecnologia. Este livro foi escrito com esse objetivo.

[1] Os limites da função 1/x tendem a +∞ quando nos aproximamos de zero pela direita (valores positivos) e a −∞ quando nos aproximamos pela esquerda (valores negativos), criando comportamentos divergentes e indefinidos que não podem ser resolvidos com um único valor.