Fonte: dos autores

Se a IA fosse uma pessoa, ela já teria 72 anos no ano de lançamento do ChatGPT, ou um pouco mais ou menos, dependendo do marco histórico escolhido para caracterizar seu “nascimento”. Muitas pessoas se surpreendem com esse fato. Antes do novo milênio, apenas uma parcela reduzida da população tinha acesso a computadores e à internet, o que tornava os efeitos da IA menos perceptíveis em nossa sociedade. No entanto, o desconhecimento sobre os avanços da IA ao longo da história não deve levar à conclusão de que essa tecnologia surgiu com o ChatGPT. Precisamos reconhecer que as tecnologias generativas são fruto de nossa cultura, resultados de desenvolvimentos técnico-científicos realizados ao longo de várias décadas.

Embora hoje a IA esteja amplamente presente em nosso cotidiano, a ideia de máquinas capazes de realizar atividades intelectuais era ficção científica até meados do século XX. Um dos primeiros passos para transformar essa ficção em realidade foi a automação da capacidade humana de realizar cálculos, uma habilidade cognitiva complexa.

Em 1936, a palavra “computador” tinha um sentido bem diferente do que tem hoje. Ela significava uma pessoa real, com papel e lápis, envolvida em cálculos aritméticos. Bancos contratavam muitas dessas pessoas, muitas vezes mulheres, para calcular os pagamentos de juros. […] Computadores humanos eram vitais ao mundo moderno, lidando com as enormes quantidades de informação produzidas à medida que ciência e indústria ficavam mais complexas. O que Turing fez em seu artigo de 1936 foi perguntar uma questão simples, mas profunda: o que passa na mente de uma pessoa ao fazer uma computação? […] O cérebro é um sistema biológico muito complexo, capaz de ter consciência, pensamentos e ideias, mas, para Turing, nada disso era importante para o processo da computação. Turing percebeu que, para se computar algo, era preciso seguir um conjunto de regras precisamente, e só isso. Ele tira a inteligência de alto nível, o pensamento, que se supunha estar envolvida no cálculo, e diz que podemos ter um processo mecânico, e por mecânico ele quer dizer um processo não pensante para realizar o mesmo ato. Portanto, ele elimina a necessidade da agência humana com todas as suas funções cognitivas de alto nível. E é isso que é revolucionário sobre o que ele tentou fazer. A mente brilhante de Turing viu que qualquer cálculo tem dois aspectos: os dados e as instruções sobre o que fazer com esses dados. E isso seria a chave para a sua descoberta. (BBC, 2012, 32:38 – 35:11)

O uso da linguagem, uma das características mais marcantes da espécie humana, tornou-se também uma capacidade das máquinas. Os modelos de linguagem de grande escala demonstraram que textos, imagens, sons e vídeos também podem ser produzidos por processos não humanos, utilizando apenas dados e operações matemáticas:

- dados: uma grande quantidade de dados é usada para treinar um modelo matemático de linguagem baseado em uma rede neural artificial;

- operações matemáticas: o prompt da/o usuária/o é processado pelo modelo de linguagem para gerar um novo conteúdo semelhante aos de seu treinamento.

Tais modelos geram textos mais rápido do que conseguimos ler, resolvem problemas complexos, criam imagens impressionantes em segundos, compõem músicas, poemas e roteiros de filmes, entre muitas outras atividades criativas. Muito do que antes acreditávamos ser uma criação exclusiva do “espírito humano” agora também é produzido por IA; assim como, no passado, a capacidade da inteligência humana de calcular foi automatizada pelos primeiros computadores.

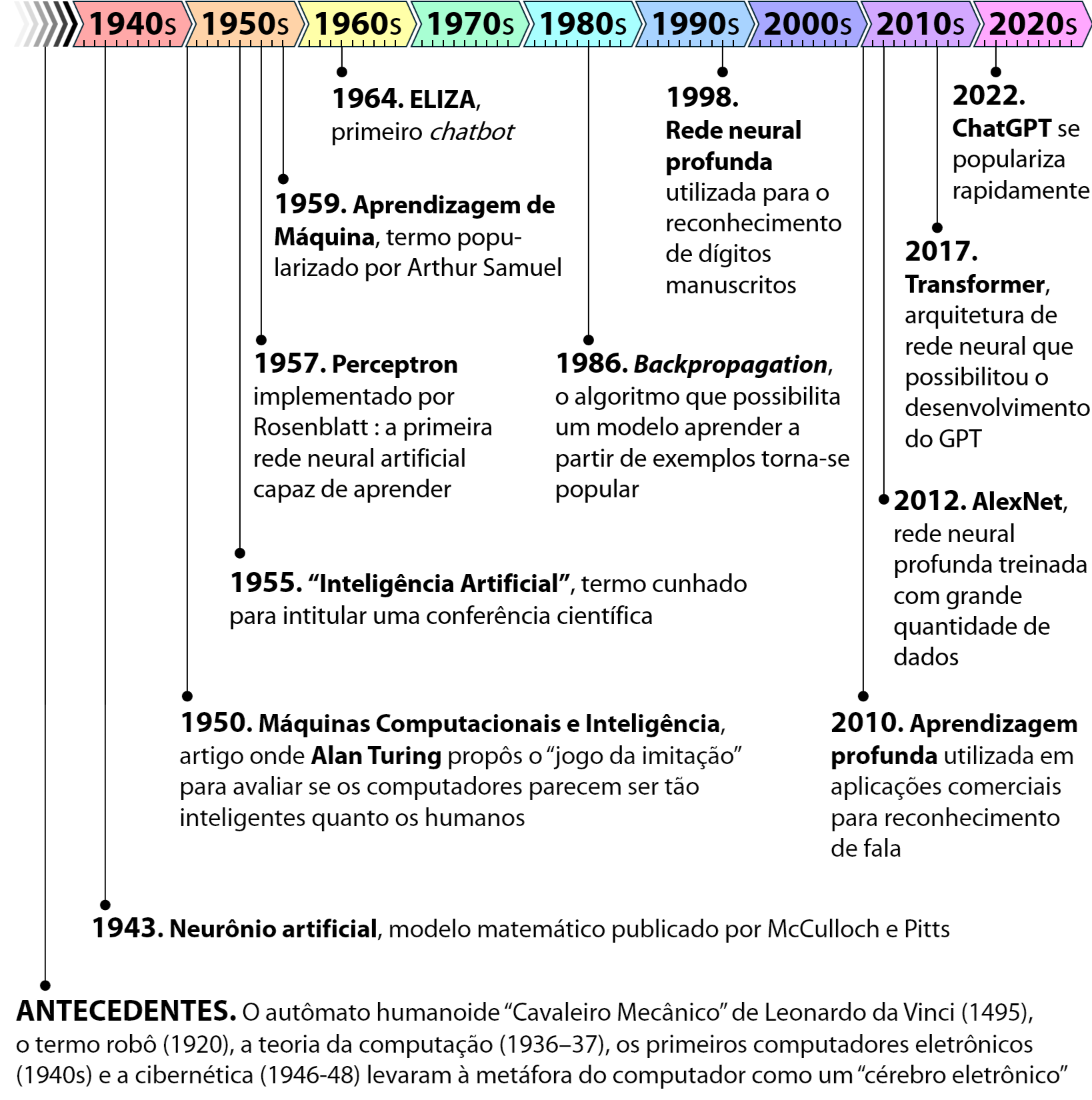

O marco do início da IA é atribuído ao artigo de McCulloch e Pitts, publicado em 1943, no qual foi apresentado um modelo matemático de um neurônio artificial que serviu de base para o desenvolvimento das redes neurais artificiais utilizadas na criação de modelos de linguagem avançados.

Nós, autores, preferimos considerar o marco inicial da IA como sendo o artigo de Alan Turing — Máquinas Computacionais e Inteligência[1] —, publicado em 1950, em que ele questiona se as máquinas podem pensar. Naquela época, Turing já vislumbrava que computadores avançados poderiam jogar xadrez e conversar como pessoas desde que recebessem instruções suficientemente detalhadas. Quanto mais complexa a tarefa, mais elaboradas precisariam ser as instruções. Nesse mesmo artigo, Turing teorizou o que hoje conhecemos como chatbot: um programa computacional capaz de conversar como se fosse uma pessoa.

Já o termo Inteligência Artificial foi cunhado em 1955 na proposta do workshop intitulado Dartmouth Summer Research Project on Artificial Intelligence, proposto por McCarthy, Minsky, Rochester e Shannon (1955). Esse evento, realizado no ano seguinte, marcou o início desse campo como área acadêmica de pesquisa.

Em 1966, foi desenvolvido o programa computacional ELIZA, identificada como a primeira chatbot da história. A matriarca de todos os chatbots já tinha 56 anos quando o ChatGPT foi lançado. Definitivamente, ele não é um produto criado do nada, de forma repentina.

Os primeiros anos de desenvolvimento da IA, até meados da década de 1970, foram marcados por grande otimismo e pelo desenvolvimento dos primeiros programas que tornaram possível um computador jogar xadrez, resolver problemas lógicos e processar a língua humana. As/Os pesquisadoras/es daquela época estavam muito entusiasmadas/os e acreditavam que a IA poderia resolver qualquer problema intelectual.

Em geral, a classe intelectual dos anos 1950 preferia acreditar que “uma máquina nunca poderá realizar X”. Os pesquisadores de IA respondiam naturalmente demonstrando um X após outro. John McCarthy se referiu a esse período como a era do “Olhe, mamãe, sem as mãos!” (Russell; Norvig, 2022, n.p.)

Hoje, diríamos que a IA estava no “pico das expectativas infladas” do Ciclo de Hype de Gartner (Gartner Hype Cycle, s.d.)[2]. Após o pico, vem o “vale da desilusão”: as expectativas iniciais não se concretizaram nos anos seguintes. Muitos problemas demandavam uma quantidade enorme de cálculos, inviável de ser processada com o poder computacional e as técnicas disponíveis na época. Como consequência, alguns governos reduziram o financiamento para pesquisas na área, e empresas que prometiam avanços ambiciosos acabaram falindo. Esse período ficou conhecido como o “inverno da IA” (Russell; Norvig, 2022).

A partir de meados da década de 1980, houve um ressurgimento das redes neurais artificiais, cujos princípios remontam à década de 1960. Esse renascimento foi impulsionado pela popularização do algoritmo de backpropagation (retropropagação), que possibilitou que máquinas aprendessem a partir de exemplos. Ocorreu, então, uma mudança de paradigma: a IA simbólica, baseada em regras e lógica formal, cedeu espaço à abordagem conexionista, que emprega métodos estatísticos e probabilísticos para substituir a programação humana pela aprendizagem automática (machine learning) (Russell; Norvig, 2022).

Com a abertura da internet para uso comercial em meados da década de 1990, a popularização dos smartphones nos anos 2000 e o uso cada vez mais intensivo das tecnologias computacionais pela sociedade, a quantidade de dados digitais aumentou consideravelmente. Hoje, dados são produzidos continuamente por diversas fontes: redes sociais, dispositivos móveis, sensores, transações online etc. Esses dados passaram a ser coletados, armazenados, processados e utilizados para criar valor, configurando o que algumas/uns autoras/es descrevem como “capitalismo de dados”, metáfora em que os dados são o “novo petróleo”. A ampla disponibilidade online de textos e imagens é o que possibilita o treinamento dos modelos de linguagem com grande quantidade de dados.

Na década de 2010, a técnica de aprendizagem profunda (deep learning) ganhou notoriedade. Embora tenha sido testada desde a década de 1970 e alcançado sucesso na identificação de algarismos manuscritos nos anos 1990, seu potencial começou a ser amplamente reconhecido a partir de 2010, com aplicações em reconhecimento de fala e visão computacional. Esse avanço técnico desencadeou uma revolução em diversas áreas, como diagnóstico médico, tradução automática e geração de conteúdos digitais.

A aprendizagem profunda exige hardware poderoso, capaz de processar grandes quantidades de dados de forma eficiente. O avanço no poder computacional, incluindo o uso de GPUs[3] e computação em nuvem, favoreceu o desenvolvimento de diversas aplicações de aprendizagem profunda, como reconhecimento de imagem e voz, sistemas de recomendação, assistentes virtuais e chatbots.

A IA generativa é fruto desse histórico de avanços nas técnicas e no processamento computacional. Ela representa o estado da arte em redes neurais artificiais profundas e demonstra que os avanços da IA chegaram a um nível de sofisticação capaz não apenas de imitar, mas, em alguns casos, de superar a capacidade humana em determinadas tarefas, confirmando as previsões otimistas das/os pioneiras/os da área.

____________________

[1] Computing Machinery and Intelligence (Turing, 1950)

[2] https://www.gartner.com/en/chat/gartner-hype-cycle

[3] As GPUs — Unidades de Processamento Gráfico — são processadores especializados originalmente projetados para a renderização de gráficos, mas que também são usadas no processamento paralelo de grandes quantidades de dados, sendo amplamente utilizadas para acelerar o treinamento de modelos de inteligência artificial.