“O ChatGPT é realmente inteligente?” — um professor universitário nos fez essa pergunta em 2023 após ter visto uma reportagem no Fantástico ([Inteligência[…], 2023), quando essa tecnologia começava a se popularizar em nosso país e no mundo. Esse questionamento nos motivou a escrever sobre IA generativa e educação, para tentarmos dar uma resposta a essa e outras dúvidas de docentes que desejam compreender as tecnologias generativas e suas implicações na educação.

Fonte: dos autores, ilustração de Mônica Lopes

10.1 – A inteligência da IA

Perguntamos ao ChatGPT: O que você é? Você é inteligente?

— Eu sou um modelo de linguagem artificial criado pela OpenAI, especificamente baseado na arquitetura GPT-4. Não tenho consciência, sentimentos ou desejos; sou apenas um programa de computador projetado para entender e gerar texto com base nos prompts que recebo. […]

Eu sou projetado para simular um certo nível de inteligência através do processamento e geração de texto, mas é importante entender que essa “inteligência” é artificial e limitada. Eu posso analisar e gerar respostas para perguntas, criar texto de forma coerente e realizar uma variedade de tarefas relacionadas à linguagem natural. No entanto, eu não tenho consciência, autoconsciência, emoções ou intuição. Minha “inteligência” é baseada em algoritmos, padrões de dados e as instruções programadas por meus desenvolvedores.

Então, embora eu possa ser uma ferramenta útil para fornecer informações e ajudar em tarefas específicas, minha inteligência não é comparável à inteligência humana complexa e multifacetada. Eu sou apenas uma ferramenta avançada de processamento de linguagem natural, não uma entidade consciente. (OpenAI, 2023i)

“Apenas uma ferramenta”? Quanta humildade! Respeitosamente, discordamos dessa caracterização e preferimos a síntese feita por Harari (2024, p.22): “A IA não é uma ferramenta — é um agente”. Ela age sobre o nosso mundo. Algumas aplicações, como a tecnologia chinesa Manus que se autointitula “O agente de IA de propósito geral”, são capazes de realizar diferentes tarefas a partir de comandos, como criar um website ou usar um navegador web para diversas finalidades: compra online (desde que a/o usuária/o autorize o débito pelo cartão), interagir numa rede social, monitorar e resumir as notícias de um jornal online, analisar e responder webmail etc.

A IA generativa é uma entidade maquínica capaz de produzir textos, às vezes, tão bem ou melhor que muitas/os de nós. Em um curso que fizemos com Lucia Santaella (2023c), ela apresentou um texto que o ChatGPT havia escrito e desabafou: “Esse exemplo me deixou com um sentimento de inferioridade. Eu já escrevi sobre ‘lágrimas na chuva’; ele escreveu melhor que eu.” Dada a admiração que temos pelos textos dessa autora, essa declaração dissipou qualquer competição ou constrangimento que ainda pudéssemos sentir ao nos compararmos ao ChatGPT. Ela nos fez lembrar que não adianta competir com a IA, essa é uma luta inglória: cedo ou tarde conseguem desenvolver uma tecnologia inteligente capaz de fazer uma tarefa melhor que nós, humanas/os.

Antes do lançamento do ChatGPT, os marcos da IA em superar certas capacidades da inteligência humana pareciam distantes do nosso cotidiano e pouco preocupantes. Essa nossa percepção foi repentinamente transformada com os modelos de linguagem de grande escala, que ampliaram as implicações da IA em nossa sociedade, causando impacto imediato no contexto educacional (como discutido na Parte I deste livro). Essa transformação ocorreu porque conseguiram desenvolver tecnologias generativas capazes de simular bem aquilo que é mais característico do humano: a linguagem.

Quando os computadores começaram a ser desenvolvidos nas décadas de 1940 e 1950, muita gente achava que eles só seriam bons para lidar com números. A ideia de que viessem a dominar as complexidades da linguagem e de criações linguísticas como leis e moedas se limitava quase à esfera da ficção científica. Mas, no começo dos anos 2020, os computadores já demonstravam uma capacidade notável de analisar, manipular e gerar linguagem, por meio de palavras, sons, imagens ou símbolos de código. Enquanto escrevo isso, os computadores são capazes de contar estórias, compor músicas, criar imagens, produzir vídeos e, até mesmo, escrever seu próprio código. Ao adquirirem esse domínio da linguagem, os computadores se apossam da chave mestra que abre as portas de todas as nossas instituições, de bancos a templos. Usamos a linguagem para criar não apenas códigos jurídicos e mecanismos financeiros, mas também arte, ciência, nações e religiões. O que significaria para os humanos viver num mundo em que melodias que ficam na cabeça, teorias científicas, ferramentas técnicas, manifestos políticos e até mitos religiosos fossem criados por uma inteligência alienígena não humana capaz de explorar, com eficiência sobre-humana, as fraquezas, as predileções e os vícios da mente humana? (Harari, 2024, p. 303)

Muitas vezes, diferenciamos o ser humano de outros animais por sua inteligência e capacidade de se comunicar por meio da linguagem, esse complexo sistema que possibilita expressar e compartilhar informações, pensamentos, conhecimentos, experiências e emoções; que possibilita conversar, interagir e colaborar; e que estrutura nossas relações sociais e práticas de cultura. A IA generativa, com sua impressionante capacidade de processar e gerar textos, imagens, sons e vídeos, colocou em xeque a ideia de que a linguagem é uma competência exclusiva da inteligência humana.

Esse acontecimento deixou em alerta, de orelha em pé, todas as pessoas que trabalham com texto, como professoras/es, cientistas, programadoras/es, escritoras/es, tradutoras/es, roteiristas, jornalistas, advogadas/os, produtoras/es de conteúdo, entre outras. O impacto também foi sentido por quem lida com imagens, sejam fotógrafas/os, ilustradoras/es, designers ou artistas; e por quem atua com som, como cantoras/es, musicistas e dubladoras/es. A capacidade da IA de gerar conteúdo em múltiplas linguagens desafia profissões, exigindo adaptação às novas tecnologias e reflexão crítica sobre suas implicações éticas, sociais e econômicas.

Para o nosso alívio, o conteúdo gerado por IA nem sempre é melhor do que o nosso. Essa tecnologia produz textos com base no que aprendeu a partir do processamento de uma enorme quantidade de textos humanos, com diferentes pontos de vista sobre variados assuntos, por isso é capaz de escrever sobre praticamente qualquer tema. Contudo, como resultado da trituração e moagem dos textos humanos, acaba por produzir um texto “pasteurizado”, “sem alma”, “basicão”, entre outras caracterizações que já ouvimos sobre suas respostas verborrágicas e formais, com redação estruturada em introdução, desenvolvimento e conclusão. Como se baseia nas afirmações mais recorrentes, seus textos não apresentam ideias muito inovadoras ou inquietantes, e sua estilística não surpreende. Para alívio das pessoas que temem que sua capacidade intelectual seja suplantada por um ser maquínico, podemos reconhecer que a IA generativa ainda não é uma escritora extraordinária (mas precisamos atentar que ela está em constante evolução). Felizmente, para a maioria de nós, também não precisamos ser Clarice, Guimarães, Drummond, Amado ou Evaristo.

Se, por um lado, ainda preferimos os nossos textos, por outro, já não abrimos mão de usar a IA generativa para nos apoiar na revisão do texto, na tradução, na elaboração de rascunhos iniciais, na conceituação, na exemplificação, na melhoria da argumentação e em outras atividades do processo de escrita de textos acadêmicos. Nossa aposta é na parceria com a IA; não em nossa substituição. Ao menos por enquanto.

10.2 – O que é ser “inteligente” para a Computação?

Para quem é da área de Computação, a resposta à questão em discussão neste capítulo é óbvia: a IA é realmente inteligente. A Inteligência Artificial é o ramo da Ciência da Computação dedicado ao desenvolvimento de algoritmos, modelos e sistemas computacionais que possibilitem às máquinas realizar tarefas que normalmente exigiriam inteligência humana, como raciocínio, tomada de decisão, percepção e aprendizagem.

Na Computação, é comum o uso de termos relacionados à cognição humana para descrever tanto o hardware (ex.: memória) quanto o software, especialmente na área de IA: inteligência (artificial ou computacional), aprendizagem (de máquina), visão (computacional), raciocínio (lógico, probabilístico, automático ou computacional), criatividade (computacional), emoção (computacional, artificial ou simulada), entre outros. Ainda que a área empregue adjetivos nesses termos para evidenciar que são metáforas, na prática, muitas pessoas tendem a ignorar essa adjetivação e acabam interpretando esses conceitos como equivalentes exatos das capacidades humanas. Isso resulta em equívocos sobre a natureza e as limitações dessas tecnologias, gerando expectativas irreais e temores infundados.

Ao contrário do que muitas pessoas imaginam, inteligência artificial não significa que a máquina pensa como as/os humanas/os, mas sim que tem a capacidade de aprender ou de tomar decisões plausíveis em situações de incerteza, simulando inteligência. Uma calculadora, por exemplo, não é inteligente, pois não aprende coisas novas nem lida com incertezas. Já um programa que joga xadrez precisa utilizar técnicas heurísticas para estimar qual seria uma boa jogada, simulando uma decisão inteligente.

Para algumas pessoas, um programa precisaria ser melhor que nós para ser considerado “inteligente”. Contudo, esse não é o critério adotado na Computação para a definição de inteligência artificial. Não se exige que o sistema acerte sempre, conheça tudo ou resolva qualquer problema — nós, humanas/os, também não conseguimos. Um sistema computacional não precisa jogar melhor que nós para ser considerado inteligente, nem sequer precisa ser um bom jogador; o que importa é que seja capaz de tomar decisões coerentes e plausíveis, mesmo que não sejam as melhores.

Para a Computação, um sistema inteligente não tem a ver com o grau de esperteza, nem com consciência, autonomia, compreensão do sentido das palavras, criatividade, emoções ou outras capacidades humanas. Um sistema pode realizar tarefas aquém da capacidade humana e ainda assim ser considerado inteligente do ponto de vista computacional. Todavia, o objetivo é desenvolver sistemas que realizem bem uma tarefa; por isso, as técnicas computacionais vão sendo aprimoradas até conseguirem realizar a tarefa tão bem quanto nós ou ainda melhor.

Um marco da capacidade dos computadores de realizarem uma tarefa melhor do que nós foi a derrota do campeão mundial de xadrez, Garry Kasparov, em 1997, para o computador Deep Blue, da IBM. Na década anterior, em 1985, Kasparov havia jogado contra 32 computadores simultaneamente e vencido todas as partidas (Kasparov, 2010). O que o fez perder 12 anos depois foi um computador e uma inteligência artificial muito mais potentes: “um supercomputador e um software criados pela IBM especialmente para jogar xadrez, com 256 coprocessadores capazes de analisar aproximadamente 200 milhões de posições por segundo” (DeepBlue, s.d.). Além de realizar muitos cálculos por segundo para avaliar matematicamente as consequências de várias jogadas, aquela inteligência artificial também consultava uma base de dados com mais de 700 mil partidas dos melhores jogadores de xadrez.

Quanto maior a base de dados, mais exemplos o computador tem sobre como agir bem em determinadas situações; quanto maior a capacidade de processamento, mais movimentos podem ser analisados por segundo. O computador venceu o maior jogador de xadrez porque tinha muitos dados para consultar, grande capacidade de processá-los e um algoritmo para tomar uma boa decisão dentro do tempo limite de cada jogada. O documentário The man vs the machine (Marshall, 2014) conta uma versão dessa história:

O xadrez, por milhares de anos, tem sido algo que nós costumávamos usar para medir a inteligência; e se um computador pudesse derrotar um humano que realmente sabe o que está fazendo no tabuleiro de xadrez, então você sabe que estamos falando de 2001: Uma Odisseia no Espaço — os computadores podem fazer qualquer coisa! (The man vs the machine, Marshall, 2014, 1:00-1:20)

A IA superou outros campeões mundiais em jogos famosos: em 2011, o sistema inteligente Watson derrotou os melhores jogadores de Jeopardy!, um famoso programa de perguntas e respostas da televisão norte-americana; em 2016, o programa AlphaGo derrotou Lee Sedol, um dos melhores jogadores de Go, um jogo de tabuleiro mais complexo que o xadrez.

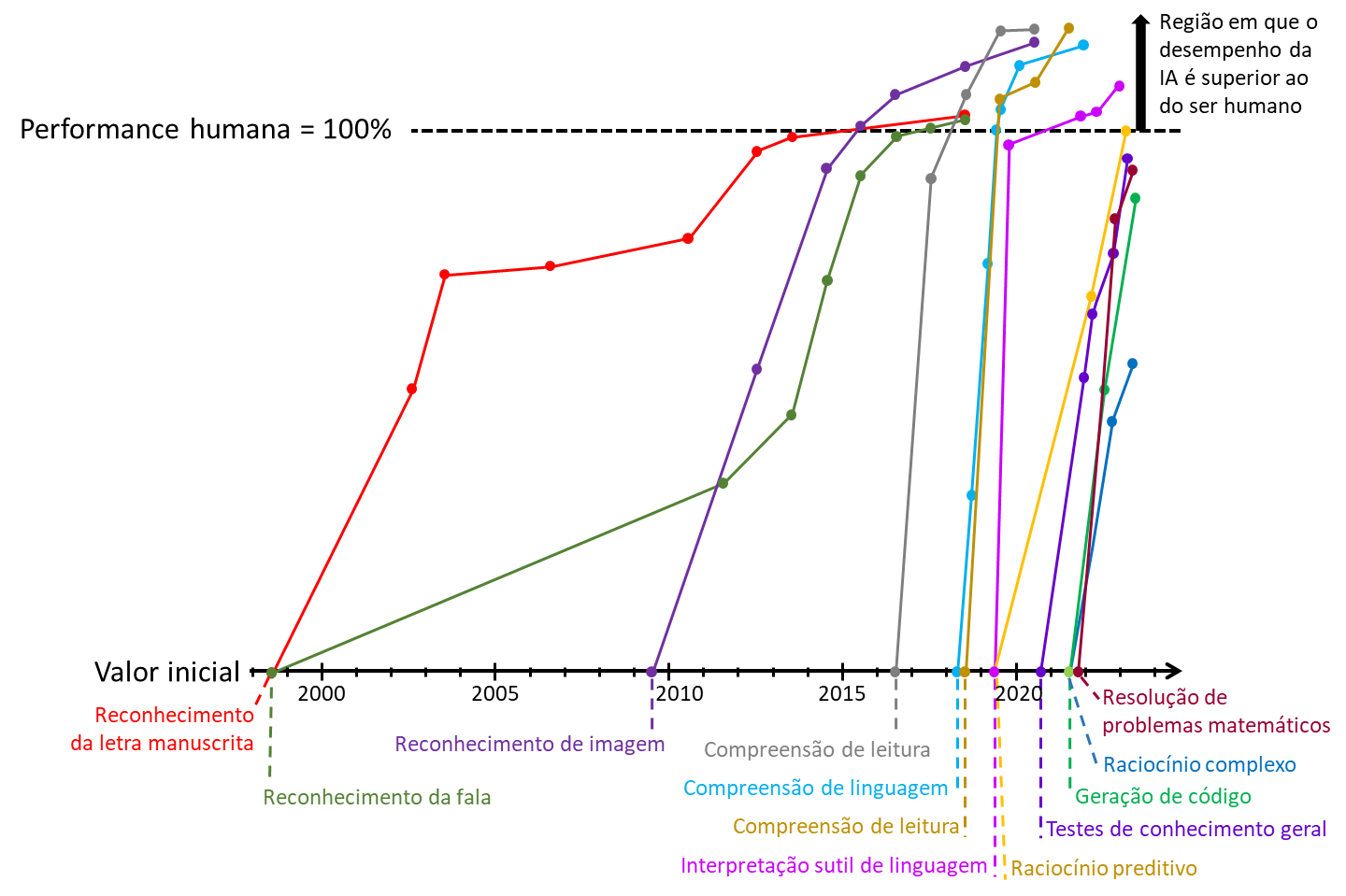

A IA já superou a capacidade humana em diversos testes de desempenho (benchmarks) e tem aprimorado rapidamente seu desempenho em diferentes áreas: conhecimento geral, interpretação de textos, resolução de problemas matemáticos, entre outras, conforme ilustrado na figura a seguir. A IA vem superando, cada vez mais rapidamente, a capacidade humana nos diferentes testes criados para a sua avaliação. Essa é uma consequência das técnicas de aprendizagem profunda desenvolvidas a partir da década de 2010, dos avanços de hardware e dos maciços investimentos realizados em IA.

Fonte: (Kiela et al., 2023; Test […], 2024)

Do ponto de vista da Computação, a IA generativa é considerada inteligente não por pensar como nós, nem por escrever textos melhores que os nossos (ou não), mas sim por ser capaz de aprender a gerar respostas coerentes e contextualmente adequadas, ainda que apresente “alucinações” ou gere respostas imprecisas. O compromisso da IA generativa não é gerar as melhores respostas, os melhores textos, ou acertar sempre; seu compromisso é gerar um novo conteúdo que seja semelhante aos dados usados em seu treinamento.

A inteligência da IA generativa reside na capacidade de simular respostas plausíveis. Essa capacidade resulta do uso de algoritmos de aprendizagem de máquina que processam grandes volumes de dados para extrair padrões linguísticos, tornando-se capazes de simular aspectos da inteligência humana, como a capacidade de interpretar perguntas, formular respostas e lidar com situações imprevistas. No entanto, essa inteligência é estritamente estatística e limitada aos padrões aprendidos durante o treinamento. Portanto, a IA generativa é considerada inteligente mesmo sem compreender o significado das palavras, sem possuir consciência, intenções, emoções ou habilidade de pensar como as pessoas.

10.3 – Comparando a inteligência artificial com a humana: o Teste de Turing

“As máquinas podem pensar?” — essa é a questão que abre o artigo Máquinas de Computação e Inteligência, de Alan Turing (1950). Reconhecendo que as máquinas obviamente processam de modo diferente de nós (porque realizam operações matemáticas-eletrônicas em vez de processos químicos-orgânicos), Turing propôs uma abordagem pragmática para avaliar objetivamente a inteligência da máquina. Ele elaborou o experimento mental que chamou de “Jogo da Imitação”, posteriormente conhecido como Teste de Turing: se os computadores conseguirem imitar o comportamento humano em uma conversação, de tal modo que não consigamos ter certeza se estamos conversando com uma pessoa ou com uma máquina, então poderíamos afirmar que são tão inteligentes quanto nós.

Essa discussão foi abordada no filme O Jogo da Imitação (Tyldum, 2014). No filme, Alan Turing explicou o “Jogo da Imitação” durante o interrogatório em que estava sendo acusado de um suposto ato homossexual, o que era considerado crime na Inglaterra daquela época (a maior parte do filme se passa durante a 2ª Guerra Mundial, mas o interrogatório ocorre em 1951):

Investigador: — As máquinas podem pensar?

Alan Turing: — Ah, andou lendo alguns artigos meus, não é?

— Por que acha isso?

— Bom, porque estou sentado em uma delegacia acusado de pagar um jovem para tocar no meu pênis, e você vem me perguntar se máquinas podem pensar?

— E aí, elas podem? As máquinas podem vir a pensar como seres humanos?

— A maioria das pessoas diz que não.

— O senhor não é a maioria.

— O problema é que está fazendo uma pergunta idiota.

— Estou?

— É claro que as máquinas não podem pensar como as pessoas. Uma máquina é diferente de uma pessoa. Bom, elas pensam diferente. A pergunta interessante é: só porque algo pensa diferente de você, significa que não está pensando? Nós aceitamos que os humanos tenham tantas divergências entre si: você gosta de morangos e eu detesto patinar, você chora em filmes tristes e eu sou alérgico a pólen. Qual é a vantagem de tantas diferenças, tantas preferências, a não ser dizer que nosso cérebro funciona diferentemente, que pensamos diferentemente? Se podemos dizer isso de nós mesmos, por que não podemos dizer o mesmo para cérebros feitos de cobre e aço?

— E foi esse o artigo que escreveu? Qual o nome dele?

— Se chama “O jogo da imitação”.

— Certo… e é esse o assunto dele?

— Gostaria de jogar?

— Jogar?

— Um jogo. Um teste cego para determinar se algo é uma máquina ou um ser humano.

— E como eu jogo?

— Bom, tem um juiz e um suspeito. O juiz faz perguntas ao suspeito, dependendo das respostas do suspeito, o juiz determina com quem ele está falando, com o que ele está falando. Tudo o que precisa fazer é uma pergunta. (O jogo da imitação, Tyldum, 2014, 01:06:43 – 01:09:18)

O objetivo do Teste de Turing não é provar que um computador é inteligente em termos teóricos, filosóficos ou teológicos, mas sim discutir os efeitos que provoca em nós: se não conseguimos diferenciá-lo de uma pessoa, a questão sobre ele ser realmente inteligente torna-se irrelevante em termos práticos. Será que o ChatGPT consegue passar nesse teste?

A capacidade do ChatGPT de passar no Teste de Turing é um tópico em debate. De um lado, o modelo tem mostrado uma habilidade impressionante de compreender e responder perguntas em língua natural de maneira coerente e relevante, muitas vezes confundindo pessoas pela semelhança de suas respostas às respostas humanas. No entanto, o GPT ainda tem limitações: ele não tem consciência ou compreensão semântica, nem pode aprender ou adaptar-se a novas informações após seu ponto de corte de conhecimento (junho de 2021, no caso do GPT-3.5). Ademais, algumas de suas respostas podem revelar-se incoerentes ou factualmente incorretas quando questionado em profundidade ou sobre tópicos mais complexos. Portanto, embora possa passar em versões mais superficiais do Teste de Turing, ainda existe um longo caminho a percorrer para que seja indistinguível de um humano em todas as situações.

Você percebeu que o parágrafo anterior foi escrito pelo ChatGPT? Se passou despercebido, então o ChatGPT passou no Teste de Turing, pois aquele texto foi gerado como resposta ao nosso pedido: “Escreva um parágrafo discutindo se o ChatGPT passaria no Teste de Turing.” (OpenAI, 2023f). Para você não se sentir mais enganada/o, garantimos que os demais parágrafos deste texto foram todos escritos por nós, autoreshumanos… mas agora você já não tem certeza se as outras partes foram realmente escritas por nós ou pelo ChatGPT? Pois é… no jogo da linguagem, ele nos imita bem. Ainda por cima, produz textos velozmente, muito mais rápido do que nossa capacidade de leitura.

É tentador pensar que o Watson [uma IA desenvolvida pela IBM] “deveria” raciocinar como os humanos. Mas eu diria que isso é superstição. No mundo real, o que importa é como um ser inteligente age. Se diferentes processos computacionais levarem uma futura IA a fazer descobertas científicas inovadoras ou a escrever romances comoventes, por que deveríamos nos importar com o modo como essas façanhas foram engendradas? E se uma IA é capaz de proclamar com eloquência a sua própria consciência, que bases éticas poderíamos ter para insistir que apenas a nossa própria biologia pode dar origem a uma senciência que valha a pena? O empirismo do Teste de Turing coloca firmemente o nosso foco no lugar onde deveria estar. (Kurzweil, 2024, p. 90)

Os pesquisadores Jones e Bergen (2024) avaliaram os modelos GPT e concluíram que “As pessoas não conseguem distinguir o GPT-4 de uma pessoa em um Teste de Turing”. Para nós, autores deste livro e professores universitários, desde o lançamento do ChatGPT tem se tornado cada vez mais difícil afirmar se um texto apresentado por um/a estudante foi escrito somente por ela/e, somente pela IA, ou se é um resultado de cocriação humano-IA.

O Teste de Turing, embora amplamente conhecido e citado, não é necessariamente o teste mais adequado para avaliarmos a inteligência de uma IA. Para que o comportamento de uma tecnologia generativa fosse indistinguível do humano, seria necessário ajustar algumas de suas capacidades: reduzir a velocidade da geração dos textos, diminuir seu conhecimento geral e limitar seu desempenho nos diversos testes até que se equiparasse ao nível médio das pessoas. Obviamente, uma IA com as mesmas dificuldades e limitações humanas não seria tão útil quanto uma inteligência notadamente superior, mais rápida e com mais conhecimentos do que nós em diversas áreas. Por exemplo, no Enem, Enade, Exame da OAB ou outras avaliações, se a IA acertasse a mesma quantidade de questões que a média das pessoas, ela não seria muito útil para quem estivesse se preparando para fazer esses testes; mas se ela acertasse todas as questões e soubesse explicar como resolver cada uma delas, então seria útil para absolutamente todas/os as/os estudantes.

Como demonstraram sistemas como PaLM 2 e GPT-4, as máquinas podem superar os humanos em tarefas cognitivamente exigentes sem serem capazes de imitar de forma convincente um humano em outros domínios. Entre 2023 e 2029, o ano em que eu espero que um programa passe no primeiro Teste de Turing robusto, os computadores alcançarão capacidades sobre-humanas numa gama cada vez maior de áreas. Na verdade, é até possível que a IA consiga atingir um nível de habilidade sobre-humano na programação antes de dominar as sutilezas sociais de senso comum exigidas no Teste de Turing. Trata-se de uma questão que ainda não foi resolvida, mas a possibilidade mostra por que a nossa noção de inteligência em nível humano precisa ser profícua e matizada. O Teste de Turing é certamente uma parte importante disso, mas precisaremos também desenvolver meios mais sofisticados de avaliar as formas complexas e variadas pelas quais a inteligência humana e a inteligência da máquina serão semelhantes e diferentes. (Kurzweil, 2024, p. 90-91).

Depois que o GPT demonstrou ser capaz de passar no Teste de Turing sob certas condições, ficou evidente que desejamos mais do que uma simples imitação da conversação humana. O foco deslocou-se da busca por máquinas que nos imitem para o desenvolvimento de tecnologias mais inteligentes do que nós. A sociedade atual não busca uma inteligência artificial indistinguível da humana em suas imperfeições e subjetividades, mas sim uma que seja capaz de resolver problemas complexos, inovar e expandir os horizontes do possível.

10.4 – Podemos concluir que a IA generativa é realmente inteligente?

Para o professor citado no início deste capítulo, não importava o algoritmo por trás do ChatGPT. Não era suficiente saber que o chatbot havia sido construído com técnicas de IA. O que ele realmente queria saber era se a IA generativa pensa como nós, se é inteligente de fato, se entende o que está escrevendo, se tem consciência.

As técnicas de inteligência artificial avançaram muito nas décadas de 2010 e 2020, mas não o suficiente para desenvolver uma consciência computacional. Contudo, pode parecer que sim, especialmente porque a IA generativa fala de si como se compreendesse a própria existência, suas habilidades e características. As expressões geradas na resposta do ChatGPT transcrita no início deste capítulo exemplificam essa aparente autoconsciência: “eu sou…”, “[fui] criado por…”, “tenho…”, “eu sou projetado para…”, “eu posso…”, “eu não tenho…”, “minha inteligência é…”, “minha inteligência não é…”, “eu não sou…”. Ainda não chegamos ao ponto de desenvolver uma inteligência artificial autoconsciente, mas podemos ser levadas/os a acreditar que sim, como aconteceu com o engenheiro de software do Google, Blake Lemoine, que afirmou que “LaMDA é senciente”. Suas crenças foram rejeitadas e ele foi demitido (G1, 2022).

Alguns filmes e obras literárias de ficção científica já discutiram um futuro possível em que computadores passariam a ter consciência, como o HAL 9000, personagem ficcional de Arthur C. Clarke, que protagonizou o filme 2001: uma Odisseia no Espaço. Já no filme ExMachina: Instinto Artificial (Garland, 2015), um programador é convidado a realizar uma avaliação inspirada no Teste de Turing: “O desafio é mostrar-lhe que ela é um robô e saber se, ainda assim, você acha que ela tem consciência”.

Para o renomado linguista Chomsky (2023), que desenvolveu a teoria da gramática generativa para explicar a capacidade humana inata de criar infinitas sentenças gramaticalmente corretas a partir de um conjunto limitado de regras, a IA generativa apenas simula a proficiência linguística sem qualquer compreensão, portanto, não pode ser considerada verdadeiramente inteligente. Essa também é a posição de Searle (1980), que formulou o experimento mental do Quarto Chinês[1] para explicar que um computador pode gerar textos sem compreender o significado das palavras, criando a ilusão de compreender uma língua.

Não, a IA generativa não entende o significado dos textos que ela mesma produz, não tem intencionalidade, ideologia ou desejos, tampouco consciência. O conhecimento verdadeiro — o conhecimento sobre o conhecimento, o conhecimento de segunda ordem, o conhecimento epistêmico — já era uma questão debatida pelos filósofos da Grécia antiga. O personagem Sócrates-platônico, no livro V da República (Platão, 1996), escrito na década de 370 a.C., já desenvolveu uma teoria do conhecimento diferenciando opinião de ciência, sendo que a primeira se refere às aparências, obtida pelo exercício da visão, e a segunda se refere ao conhecimento sobre as ideias, obtido pelo exercício da razão; trata-se de uma distinção ontológica entre o sensível e o inteligível (LaFrance, 2011). Esse conhecimento verdadeiro, os modelos de linguagem ainda não têm; por isso, às vezes, geram informações equivocadas e podem afirmar outra coisa na resposta seguinte sem qualquer constrangimento.

Embora a IA não tenha consciência até o momento em que escrevemos este livro, será que ela poderá vir a ter no futuro?

Suponha que futuros sistemas de IAG [Inteligência Artificial Geral] (na tela ou em robôs) tivessem um desempenho equiparável ao do ser humano. Será que eles teriam uma verdadeira inteligência, um verdadeiro discernimento, uma verdadeira criatividade? Será que teriam egos, postura moral, livre-arbítrio? Seriam conscientes? E, sem a consciência, será que poderiam ter qualquer uma dessas outras características?

Essas perguntas não são científicas, são filosóficas. Muitas pessoas sentem intuitivamente que a resposta, em cada um dos casos, é: “Claro que não!”.

No entanto, as coisas não são tão simples assim. Precisamos de argumentos meticulosos, não apenas de intuições precipitadas. Mas esses argumentos mostram que não existem respostas indiscutíveis para essas perguntas. Isso porque os próprios conceitos em questão são extremamente controversos. Somente se todos eles fossem satisfatoriamente compreendidos poderíamos estar seguros de que a hipotética IAG seria realmente inteligente ou não. Em suma: ninguém tem 100% de certeza.

Alguns podem dizer que isso não importa: o que importa é o que as IAGs farão realmente. (Boden, 2020, p.165-166)

Não devemos confundir inteligência com compreensão de mundo ou consciência. A IA generativa é inteligente sem compreender as palavras que escreve e sem ter consciência.

À medida que se tornam mais inteligentes, os computadores podem acabar desenvolvendo consciência e tendo algum tipo de experiência subjetiva. Mas podem da mesma forma vir a ser muito mais inteligentes do que nós, sem jamais desenvolverem sentimento algum. Já que não entendemos completamente como a consciência surge em formas de vida baseadas no carbono, não é possível prever se ela emergiria de entidades não orgânicas. Talvez a consciência não tenha nenhum vínculo essencial com a bioquímica orgânica, e nesse caso computadores conscientes podem surgir a qualquer momento. Ou talvez haja vários caminhos alternativos que levam à superinteligência, e apenas alguns desses caminhos envolvam a aquisição de consciência. Assim como aviões voam muito mais rápido do que pássaros sem precisar desenvolver penas, pode ser que os computadores venham a resolver problemas bem melhor do que os seres humanos, sem que jamais desenvolvam sentimentos. […] Via de regra, as pessoas definem e avaliam a IA pela métrica da “inteligência no nível humano”, e muito se debate sobre quando podemos esperar que as IAs atinjam a “inteligência no nível humano”. No entanto, o uso dessa métrica é terrivelmente confuso. É como definir e avaliar aeronaves pela métrica do “voo no nível do pássaro”. A IA não está avançando em direção à inteligência de nível humano. Ela evolui em direção a um tipo de inteligência totalmente diferente. (Harari, 2024, p. 257; 275)

As pessoas tendem a confundir inteligência com consciência, de modo que muitas delas concluem que entidades não conscientes não podem ser inteligentes. Mas inteligência e consciência são coisas bem diferentes. Inteligência é a capacidade de alcançar objetivos, como maximizar o envolvimento do usuário numa plataforma de rede social. Consciência é a capacidade de ter sentimentos subjetivos como dor, prazer, amor e ódio. Nos humanos e em outros mamíferos, a inteligência costuma andar de mãos dadas com a consciência. […] No entanto, é um erro extrapolar de humanos e mamíferos em geral para todas as entidades possíveis. Bactérias e plantas aparentemente não têm consciência, mas também demonstram inteligência. Coletam informações do ambiente, fazem escolhas complexas e adotam estratégias engenhosas para obter alimentos, se reproduzir, cooperar com outros organismos e escapar de predadores e parasitas. Até os humanos tomam decisões inteligentes sem ter consciência delas; 99% dos processos em nosso corpo, da respiração à digestão, acontecem sem que haja nenhuma tomada de decisão consciente. […] O mesmo ocorre com os computadores. Embora não sintam dor, amor ou medo, os computadores são capazes de tomar decisões que maximizam o envolvimento do usuário e ainda podem afetar importantes acontecimentos históricos. (Harari, 2024, p. 297)

A inteligência não é um objeto físico que possa ser mensurado diretamente; é uma construção teórica que recebe sentidos específicos em diferentes áreas do conhecimento, como na Biologia, Psicologia, Neurociência, Teologia, Educação, Filosofia e também na Ciência da Computação. Quando a inteligência é definida como um conjunto de habilidades — como planejamento, previsibilidade, associação, raciocínio, inferência, analogia, entre outras —, podemos reconhecer que algumas dessas habilidades podem ser imitadas pela IA (Boden, 2020). Essa também é a conclusão de Santaella (2023a, p. 163), para quem “a IA é inteligente porque o computador adquiriu o potencial de aprender e tomar decisões com base nas informações que recebe”.

No capítulo 12, explicamos o funcionamento da IA, pois quem conhece em mais detalhes como tudo funciona sabe que a IA generativa não pensa como nós, não compreende o que está escrevendo, não tem consciência.

10.5 – Então não somos as/os únicas/os sapiens?

Para algumas pessoas, a IA generativa representa uma ameaça à nossa própria condição de ser humano; ao menos para aquelas pessoas que desejam se colocar acima de outros seres: “somos os únicos seres inteligentes” (Homo sapiens), “os únicos capazes de produzir artefatos” (Homo habilis), “os únicos capazes de se comunicar pela linguagem” (Homo loquens), “os únicos criativos” (Homo creativus).

As/Os biólogas/os certamente discordariam de que essas características sejam exclusivas da nossa espécie. Outros animais também demonstram inteligência, como primatas, golfinhos, elefantes, polvos, cães, gatos, entre outros. A inteligência animal é avaliada por múltiplos critérios, como capacidade de memória, comunicação, aprendizagem, resolução de problemas, uso de ferramentas e comportamentos sociais complexos. Estudos nas áreas de biologia, cognição, neurociência e comportamento têm demonstrado que outras espécies também são capazes de produzir e usar ferramentas, resolver problemas, planejar o futuro, sonhar, ter emoções e empatia, apresentar comportamentos culturais e até mesmo autoconsciência. Por exemplo, elefantes usam sons para chamar outros indivíduos pelo nome e respondem quando ouvem seu próprio nome. As abelhas são capazes de informar, com precisão, onde se encontram fontes de alimento por meio da “dança das abelhas”, um comportamento comunicativo que inclui movimentos específicos para indicar a direção e a distância de um alvo em relação à colmeia. Golfinhos e baleias utilizam complexos sistemas de comunicação, produzindo uma variedade de sons — como assobios, cliques e chamadas — que transmitem informações sobre localização, estado emocional e intenções; essas vocalizações são fundamentais para socialização, caça e orientação, demonstrando a elevada inteligência e a capacidade de colaboração dessas espécies marinhas.

Podemos reconhecer que os seres humanos apresentam um grau mais complexo de inteligência, de habilidades comunicativas e de produção de artefatos mais elaborados; contudo, trata-se de um contínuo em termos de complexidade, e não capacidades exclusivas da nossa espécie. Todas as tentativas de nos colocarmos acima de outras espécies acabaram malsucedidas com o tempo e revelaram o quanto somos pretensiosas/os e narcisistas.

Sigmund Freud, no ensaio Uma Dificuldade no Caminho da Psicanálise (1917), listou três “feridas narcísicas” que abalaram o orgulho humano ao longo da história. A primeira ocorreu com a teoria heliocêntrica de Copérnico, que deslocou a Terra do centro do universo, tirando também o ser humano de uma posição privilegiada no cosmos. A segunda ferida foi causada por Charles Darwin, ao demonstrar que o ser humano evoluiu de outras formas de vida, partilhando ancestrais comuns com outros animais. Por fim, a própria psicanálise de Freud constituiu a terceira ferida, ao mostrar que não somos plenamente senhoras/es de nossos pensamentos e desejos, pois forças inconscientes modelam nosso comportamento e vida psíquica. As derrotas do narcisismo humano nos levam a questionar a imagem idealizada que cultivamos de nós mesmas/os. Agora, a IA pode representar uma nova ameaça à identidade humana, como nos alertam Russell e Norvig (2022, n.p.):

As pessoas poderiam perder seu sentido de identidade. Em Computer Power and Human Reason, Weizenbaum (1976), o autor do programa ELIZA, destaca algumas das ameaças potenciais que a IA representa para a sociedade. Um dos principais argumentos de Weizenbaum é que a pesquisa de IA torna possível a ideia de que os seres humanos são autômatos — uma ideia que resulta em perda de autonomia ou até de humanidade. Observamos que a ideia tem estado presente há muito mais tempo que a IA, desde a época de L´ Homme Machine (La Mettrie, 1748). Também observamos que a humanidade sobreviveu a outros retrocessos em nosso senso de identidade: De Revolutionibus Orbium Coelestium (Copérnico, 1543) afastou a Terra do centro do sistema solar, enquanto A descendência do homem (Darwin, 1871) colocou o Homo sapiens no mesmo nível das outras espécies. A IA, se for amplamente bem-sucedida, poderá ser pelo menos tão ameaçadora para as suposições morais da sociedade do século XXI como a teoria da evolução de Darwin foi para as suposições morais do século XIX.

Considerando as intensas reações aos avanços da IA generativa, Lucia Santaella e Dora Kaufman (2024, p. 46) concluíram que ela já está causando uma nova ferida narcísica na humanidade:

A IA generativa, por seu lado, penetrou no segredo mais íntimo do humano: o potencial linguístico e semiótico que, até então, se constituía em marca inimitável do Sapiens. […] É justamente aí, no fato de o humano se sentir de algum modo igualado em sua pretensão-chave de exclusividade, que se tem municiado a explosão sociocultural e mesmo psíquica que a IA generativa vem provocando. E isso nos leva a propor e defender a hipótese de que, com a IA no ponto em que hoje se encontra, a humanidade está em plena travessia de sua quarta ferida narcísica.

Em vez de temermos perder nossa posição exclusiva de seres inteligentes na face da Terra, podemos nos reconhecer como seres híbridos, com capacidades intelectuais estendidas pelo uso das tecnologias inteligentes. A ideia de sermos híbridos nos possibilita lançar um novo olhar sobre a própria condição humana e sobre o papel da IA em nossa sociedade. Retomaremos essa discussão na Parte III deste livro.

[1] O experimento do quarto chinês consiste em uma pessoa trancada em um quarto com um conjunto de regras sobre como manipular caracteres chineses, sendo que as regras estão escritas em uma língua que a pessoa compreende. Quando um texto em Chinês é passado por debaixo da porta, a pessoa segue as regras mecanicamente para formular uma resposta em Chinês, que é então devolvida por debaixo da porta. Como a resposta tem coerência, a pessoa do lado de fora acredita que a pessoa dentro do quarto compreende Chinês. Assim como a pessoa no quarto, a IA gera um novo texto realizando operações a partir do prompt do usuário (o texto inicial passado por debaixo da porta), sem compreender o significado das palavras recebidas e geradas.